人们已经提出了大量可能的词嵌入方法。最常用的模型是 word2vec 和 GloVe,它们都是基于分布假设的无监督学习方法(在相同上下文中的单词往往具有相似的含义)。 虽然有些人通过结合语义或句法知识的有监督来增强...

”词嵌入向量“ 的搜索结果

↑↑↑关注后"星标"Datawhale每日干货 &每月组队学习,不错过Datawhale干货作者:芙蕖,Datawhale优秀学习者,东北石油大学为了处理语...

1. 什么是词嵌入(Word Embedding)⾃然语⾔是⼀套⽤来表达含义的复杂系统。在这套系统中,词是表义的基本单元。顾名思义,词向量是⽤来表⽰词的向量,也可被认为是词的特征向量或表征。把词映射为实数域向量的技术也...

文本的词向量表示又叫文本的分布式表示,它源自于语言学家的语境理论。语言学家Firth认为:“语言是人类的生活方式,词语的含义根植于人类赖以生存的社会活动中”;也就是说,词语的含义存在于语境中,由与它搭配...

使用这些特定于域的预训练词嵌入模型(COVID-19)将比在AI任务中使用其他通用的预训练词嵌入模型更为准确。引文如果您想使用我们的预训练模型,请使用以下bibtext引用此工作: @article{alqurashi2021eating, title...

简而言之,词向量只不过是表示自然语言词含义的一系列实数。这项技术是有用的NLP功能的重要推动力,使机器能够“理解”人类语言。本文讨论如何使用词向量以编程方式计算文本的语义相似性,例如,如果您需要根据文本...

Word2Vec 词嵌入工具的提出正是为了解决上面这个问题,它将每个词表示成一个定长的向量,并通过在语料库上的预训练使得这些向量能较好地表达不同词之间的相似和类比关系,以引入一定的语义信息。基于两种概率模型的...

一、词向量 自上世纪90年代开始,特征空间模型就应用于分布式语言理解中,在当时许多模型用连续性的表征来表示词语,包括潜在语义分析LSA、隐含狄利克雷分布LDA主题模型。Bengio et al.在2003年首先提出了词向量的...

本文将介绍一种基于词嵌入的文本分类算法—— Word2Vec。Word2Vec是一种将文本转化为向量表示的方法,通过训练神经网络,实现对文本数据的分类。其核心思想是将文本中的词语转换为实数值,使得不同词语之间的距离...

词嵌入即利用向量来表示单词,表示原则是一个单词的意思是由经常出现在它附近的单词给出的,即我们需要刻画单词的上下文关系。转化成数学就是,我们需要构建一个词空间,用词空间里的向量来表示单词,相似词对应的词...

词嵌入的基本方法引入问题基本概念基于频率的词嵌入计数向量化TF-IDF向量化具有固定上下文的共现窗口共现矩阵的优点共现矩阵的缺点 引入问题 当您搜索梅西时,我们如何使计算机告诉您有关足球或罗纳尔多的信息?您...

embedding词向量的使用

标签: 机器学习

1 文本分类文本分类是自然语言处理领域最活跃的研究方向之一,目前文本分类在工业界的应用场景非常普遍,从新闻的分类、商品评论信息的情感分类到微博信息打标签辅助推荐系统,了解文本分类技术是NLP初学者比较好的...

这块,也可以参考facebook的...关于词向量对齐的历史方法,可以看这里:https://blog.csdn.net/xacecaSK2/article/details/102096256 1. 前言 在公司业务需求背景下,我需要解决来源不同语言...

词嵌入是高维向量空间中单词或短语的数字表示,其中向量之间的几何关系捕获相应单词之间的语义和句法相似性。这些表示使机器学习模型能够以更有意义的方式理解和处理自然语言。

很好的资料https://www.jianshu.com/p/a6bc14323d77

该研究分为两个项目:子词嵌入和高效文本分类。有学者认为fastText只包含高效文本分类,主张它才是该研究的重中之重。不过,在Facebook相关研究的官网,是对两个项目各给出一篇论文的链接。本文以官网为准,对两个...

【Transformer系列】深入浅出理解Embedding(词嵌入)

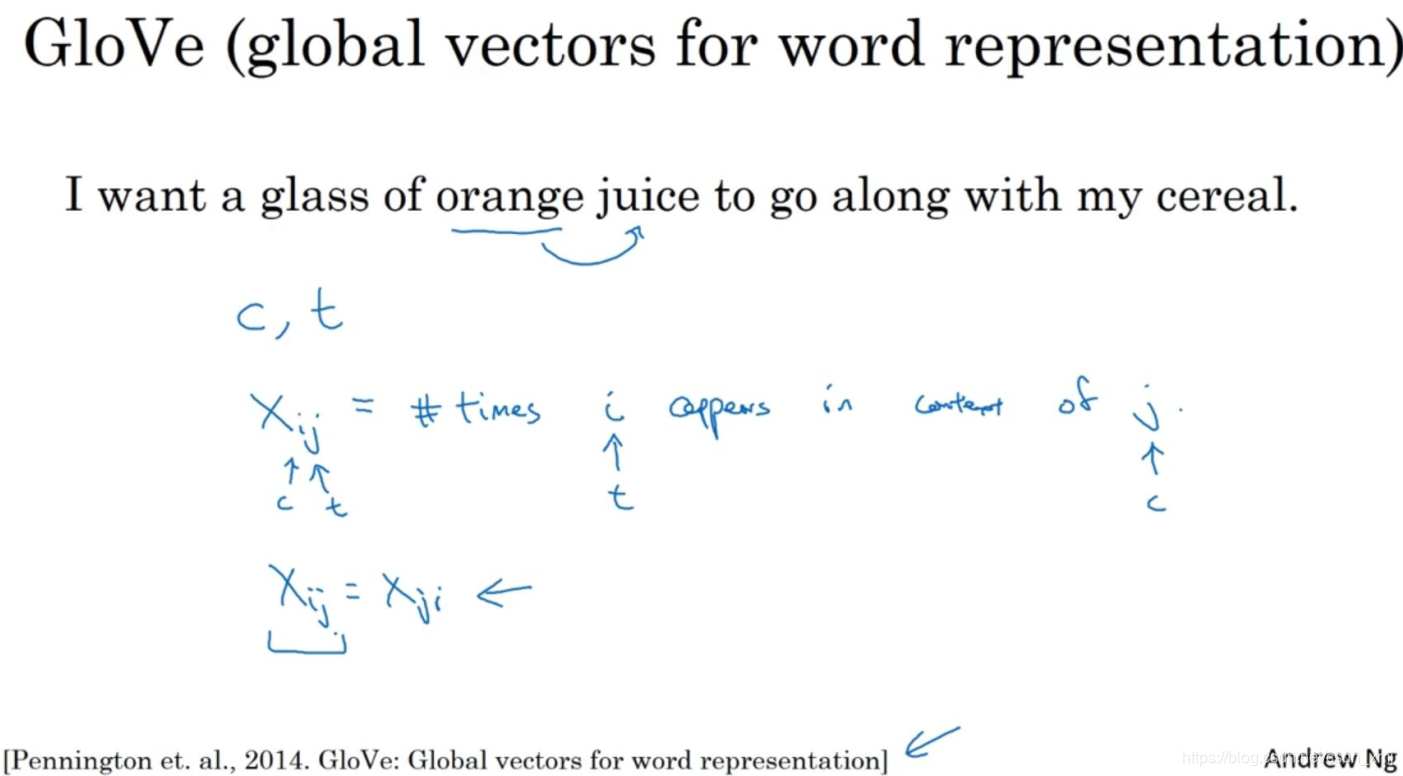

Türkçe GloVe - 土耳其语 GloVe 词嵌入存储库 训练 我们使用官方 GloVe 存储库来创建词嵌入和评估。 下载预训练的单词向量 570K 词汇,大小写,300d 矢量,1.6 GB 文本,2.6 GB 二进制 253K 词汇,无大小写,300d ...

词嵌入(Word Embedding)是将自然语言表示的单词转换为计算机能够理解的向量或矩阵形式的技术。在Word Embedding之前,常用的方法有one-hot、n-gram、co-occurrence matrix,但是他们都有各自的缺点。Word ...

嵌入表示学习是当下研究热点,从word2vec,到...但如何构建向量嵌入理论指导算法设计?最近RWTH Aachen大学的计算机科学教授ACM Fellow Martin Grohe教授给了《X2vec: 构建结构数据的向量嵌入理论》报告,非常干货!

使用词嵌入解决类比问题 4.使用词嵌入减少性别偏见等 """ import numpy as np import Deep_Learning.test5_2.w2v_utils # 加载词向量,使用五十维的向量表示单词 words, word_to_vec_map = Deep_Lea

自然语言处理(NLP)——词向量

标签: nlp

笔者在看各种NLP的论文、文献、博客之中发现在应用过程中,有种类繁多的词向量的表达。笔者举例所看到的词向量有哪些。 词向量类型: 一个词一列向量,Hash算法,word2vec,LDA主题-词语矩阵; 一个词一个值,bow...

pytorch词嵌入

标签: 深度学习

1. nn.Embedding torch.nn.Embedding(num_embeddings, embedding_dim, padding_idx=None, max_norm=None, norm_type=2, ...num_embeddings (int) - 嵌入字典的大小 embedding_dim (int) -

在NLP中,一个最基本的问题就是如何在计算机中表示一个单词。一般我们用含有N个单词的词汇表来对单词进行编码,例如词表{“hello”: 0, ...这就需要embedding操作将词向量进行压缩,用更小的维度去表示大量的词汇空间。

推荐文章

- 大数据和云计算哪个更简单,易学,前景比较好?_大数据和云计算哪个好-程序员宅基地

- python操作剪贴板错误提示:pywintypes.error: (1418, 'GetClipboardData',线程没有打开的剪贴板)...-程序员宅基地

- IOS知识点大集合_ios /xmlib.framework/headers/xmmanager.h:66:32: ex-程序员宅基地

- Android Studio —— 界面切换_android studio 左右滑动切换页面-程序员宅基地

- 数据结构(3):java使用数组模拟堆栈-程序员宅基地

- Understand_6.5.1175::New Project Wizard_understand 6.5.1176-程序员宅基地

- 从零开始带你成为MySQL实战优化高手学习笔记(二) Innodb中Buffer Pool的相关知识_mysql_global_status_innodb_buffer_pool_reads-程序员宅基地

- 美化上传文件框(上传图片框)_文件上传框很丑-程序员宅基地

- js简单表格操作_"var str = '<table border=\"5px\"><tr><td>序号</td><-程序员宅基地

- Power BI销售数据分析_powerbi汇总销售人员业绩包括无销售记录的人-程序员宅基地