分享课程——ONNXRUNTIME计算机视觉模型部署与加速教程

”模型部署“ 的搜索结果

ML模型部署

Jetson Xavier NX 下 yolov8 tensorrt模型部署流程记录及问题处理,本文使用的是TensorRT-Alpha封装库,基于tensorrt+cuda,实现模型的gpu加速。

等值模型部署

显存可以用来放模型,数据等。GPU 利用率主要的统计方式为:在采样周期内,GPU 上有 kernel 执行的时间百分比。可以简单理解为GPU计算单元的使用率。首先,异构现象是指不同计算平台之间,由于硬件结构(包括计算核心...

如果模型要求的算力比较大,就只能考虑以API的形式来调用了,这时候模型是部署在服务器上的。 桌面端:桌面应用主要包括Windows和Mac OS以及Linux,这时候我们还是需要将模型封装成SDK然后提供接口来进行调用。...

由于模型训练完之后需要上线部署,这个过程中需要将模型集成到当前的软件架构中,因此要根据软件架构考虑模型的实际部署方法。目前来看主流的部署方法有以下几种方案: 1.python服务接口 在python服务器上部署...

工业界与学术界最大的区别在于工业界的模型需要落地部署,学界更多的是关心模型的精度要求,而不太在意模型的部署性能。一般来说,我们用深度学习框架训练出一个模型之后,使用Python就足以实现一个简单的推理演示...

给大家分享一套课程——深度学习模型部署与剪枝优化实例视频教程,课程目录: 第1章 PyTorch框架部署实践 第2章 YOLO-V3物体检测部署实例 第3章 docker实例演示 第4章 tensorflow-serving实战 第5章 模型减枝-...

分享课程——OpenVINO2022计算机视觉模型部署与加速课程,附源码+模型文件+思维导图。

本文介绍了如何将训练好的机器学习模型部署到生产系统中,包括模块构建、Web应用开发和HTML页面模板创建。通过示例展示了机器学习模型的序列化、Flask框架的使用以及模型预测流程。同时强调了模型训练只需完成一次,...

亚博K210模型训练部署

标签: K210

亚博K210模型训练部署

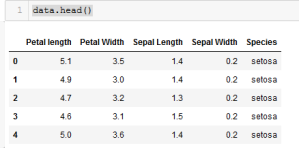

虹膜分类模型在Django中的部署虹膜分类模型在Django中的部署

以上是将训练好的使用 PyTorch 框架的 ResNet50 模型部署到 Java Web 中的具体操作步骤。使用 PyTorch 的 Keras 插件,将 ResNet50 模型导出为 PyTorch 模型。在 Java Web 应用程序中,可以使用 PyTorch 模型进行...

本文档详细介绍了使用ChatGLM3-6b大模型、m3e向量模型、one-api接口管理以及Fastgpt的知识库,成功的在本地搭建了一个大模型。此外,还利用LLaMA-Factory进行了大模型的微调。

需要注意的是,在STM32CUBEMX上安装CUBEAI时,可能并不能安装到最新版本的CUBEAI,因此可以前往ST官网下载最新版本(最新版本会对模型实现进行更新)。函数传入网络句柄,...由于部署后属于模型应用阶段,输入数据。

数字水利模型部署云流化方案有什么优势?共2页.pdf.zip

1.获取镜像:tensorflow serving docker pulltensorflow/serving 2.启动容器 3.

在模型进行部署推理时就需要不同的依赖库,而且同一个框架比如tensorflow 不同的版本之间的差异较大, 为了解决这个混乱问题, LF AI 这个组织联合 Facebook, MicroSoft等公司制定了机器学习模型的标准,这

本课程是《Tensorflow 模型 C++部署实战》部分的续集,高级部分,主要讲述,如何进行新版本移植,加载Frozen pb,? 虚拟GPU, TF-TRT优化专题,对部署框架增加更多功能和性能优化。

本文为系列博客tensorflow模型部署系列的一部分,用于实现通用模型的部署。本文主要实现用tflite接口调用tensorflow模型进行推理。相关源码见链接 引言 本文为系列博客tensorflow模型部署系列的一部分,用于tflite...

ONNX 所针对的是深度学习开发生态中最关键的问题之一,在任意一个框架上训练的神经网络模型,无法直接在另一个框架上用。开发者需要耗费大量时间精力把模型从一个开发平台移植到另一个。因此,如何实现不同框架之间...

推荐文章

- c语言链表查找成绩不及格,【查找链表面试题】面试问题:C语言学生成绩… - 看准网...-程序员宅基地

- 计算机网络:20 网络应用需求_应用对网络需求-程序员宅基地

- BEVFusion论文解读-程序员宅基地

- multisim怎么设置晶体管rbe_山东大学 模电实验 实验一:单极放大器 - 图文 --程序员宅基地

- 华为OD机试真题-灰度图恢复-2023年OD统一考试(C卷)-程序员宅基地

- 【机器学习】(周志华--西瓜书) 真正例率(TPR)、假正例率(FPR)与查准率(P)、查全率(R)_真正例率和假正例率,查准率,查全率,概念,区别,联系-程序员宅基地

- Python Django 版本对应表以及Mysql对应版本_django版本和mysql对应关系-程序员宅基地

- Maven的pom.xml文件结构之基本配置packaging和多模块聚合结构_pom <packaging>-程序员宅基地

- Composer 原理(二) -- 小丑_composer repositories-程序员宅基地

- W5500+F4官网TCPClient代码出现IP读取有问题,乱码问题_w5500 ping 网络助手 乱码 send(sock_tcps,tcp_server_buff,-程序员宅基地