”压缩加速“ 的搜索结果

模型压缩论文目录结构`structure`量化`quantization`Binarized Neural Networks: Training Deep Neural Networks with Weights and Activations Constrained to +1 or -1FINN: A Framework for Fast, Scalable ...

主要介绍了wordpress页面压缩 加速网站访问的方法,需要的朋友可以参考下

mmol石,排列分子匹配 ... 压缩过程相当缓慢,因此可以在WEBSITE上下载pubchem数据库的预压缩版本。 有关Ammolite背后的算法的更多信息,请参见PAPER 如何使用Ammolite命令行工具 命令行版本的Ammolite支持三个基

AI科技大本营在线公开课《深度学习模型压缩加速与手机移动端部署》 共47页.pptx

#资源达人分享计划#

Collection of recent methods on DNN compression and acceleration

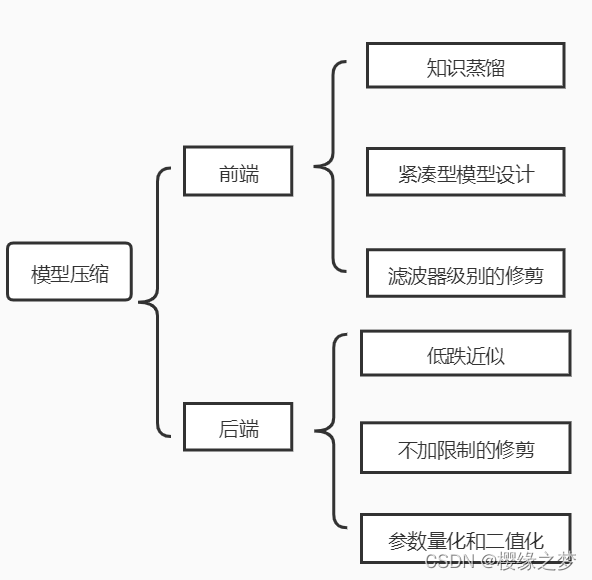

深度学习模型压缩加速方法可大致分为2大类 1、设计新的卷积计算方法 设计新的卷积计算方法,从而减少参数,达到压缩模型的效果,例如 SqueezedNet、mobileNet 比如:depth-wise 卷积、point-wise 卷积(Depthwise...

.wkpf,.wkpf1{ font-family:"微软雅黑"; font-size:13px; line-height:30px; text-decoration:none; color:#818183;}32次浏览评价:好中

可以加速播放视频,大大减小视频的体积;可以加速播放视频,大大减小视频的体积;可以加速播放视频,大大减小视频的体积;可以加速播放视频,大大减小视频的体积;可以加速播放视频,大大减小视频的体积;可以加速...

本文在回顾经典神经网络模型和现有神经网络压缩工具的基础上,总结参数剪枝、参数量化、低秩分解和知识蒸馏四类压缩方法的代表性压缩算法的优缺点,概述压缩方法的评测指标和常用数据集,并分析各种压缩方法在不同...

深度学习模型压缩与加速综述.pdf

为了在资源受限的情况下高效部署深度学习模型,模型压缩与加速成为至关重要的技术。本文将带您深入了解模型压缩与加速的核心概念,从剪枝、量化到蒸馏,为您揭示优化模型性能、提高推理速度的关键方法。 内容概要 ...

深度学习模型的压缩和加速是指利用神经网络参数的冗余性和网络结构的冗余性精简模型,在不影响任务完成度的情况下,得到参数量更少、结构更精简的模型。被压缩后的模型计算资源需求和内存需求更小,相比原始模型能够...

自从AlexNet一举夺得ILSVRC2012ImageNet图像分类竞赛的冠军后,卷积神经网络(CNN)的热潮便席卷了整个计算机视觉领域。CNN模型火速替代了传统人工设计(hand-crafted)特征和分类器,不仅提供了一种端到端的处理...

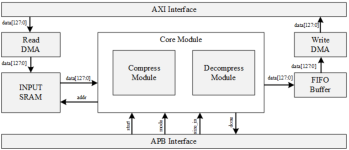

由于层III压缩算法的复杂度高,运算量大,为此提出了在实时应用中,基于数字信号处理器(Digital Signal Processor,以下简称DSP)实现层III压缩算法的关键运算的加速措施。 【关键词】 DSP MPEG 压缩编码 ...

基于时间压缩的流量加速回放方法.docx

模型压缩、硬件加速、NAS相关文献

标签: DL

模型压缩、硬件加速、NAS相关文献

1、剪枝(1)Deep Compression这篇文章(Stanford的Song Han)如图 1所示,剪枝需要三个步骤,首先是训练一个普通的神经网络;然后我们选择一个阈值,将权重小于阈值的连接剪开,这样就得到一个稀疏连接的网络了(图 ...

为什么要对网络进行压缩和加速呢?最实际的原因在于当前存储条件和硬件的计算速度无法满足复杂网络的需求,当然也许十几年或更远的将来,这些都将不是问题,那么神经网络的压缩和加速是否仍有研究的必要呢?答案是...

[References]: ... ... 神经网络的权值共享指从一个局部区域学习到的信息应用到图像的其它地方去。例如用一个相同的卷积核去卷积整幅图像,相当于对图像做一个全图滤波,每个卷积核在整个图像上是不断重复的,这些...

推荐文章

- 思科 下一跳_二层交换机下一跳命令-程序员宅基地

- IFeatureClass接口_list<ifeatureclass>-程序员宅基地

- 利用Mysql into outfile给网站留后门-程序员宅基地

- 商业智能软件对比评测: FineBI 和 Tableau -程序员宅基地

- JQuery Ajax Maven [A]_ajaxmaven-程序员宅基地

- 通信原理与MATLAB(八):2PSK的调制解调_psk解调-程序员宅基地

- Halcon 3D定位方法-程序员宅基地

- 用 Hadoop 进行分布式并行编程, 第 3 部分_hdfs dfs -copyfromlocal /home/hadoop/temp/* /tempd-程序员宅基地

- Linux进阶 apache服务器;虚拟主机_虚拟机安装开启httpd服务-程序员宅基地

- 软件测试随笔-程序员宅基地