”使用java提交spark任务“ 的搜索结果

java提交spark任务到yarn平台的配置讲解共9页.pdf.zip

java提交spark任务到yarn平台的配置讲解共9页.pdf.zip

采用spark的方式处理,所以需要将spark的功能集成到代码,采用yarn客户端的方式管理spark任务。不需要将cdh的一些配置文件放到resource路径下,只需要配置一些配置即可,非常方便 二、任务管理架构 三...

本文主要向大家介绍了JAVA语言提交spark任务到yarn平台的配置讲解,通过具体的内容向大家展示,希望对大家学习JAVA语言有所帮助。一、背景采用spark的方式处理,所以需要将spark的功能集成到代码,采用yarn客户端的...

本文基于spark-1.6.2-bin...程序中指定的参数(param)和spark-submit提交时参数配置一致: import org.apache.spark.deploy.SparkSubmit; public class Dr { public static void main(String[] args) { String[]...

client.run() client.submitApplication() client.monitorApplication

0x0 背景介绍 项目中使用SparkSession来执行任务,...为了解决以上问题,只有采用Java代码模拟Spark Submit来提交任务到集群,从而实现动态调用spark。 0x1 方法 查看多方资料,发现三个方法,分别是: 1. ...

执行java代码的一个方法,这个动作触发提交spark任务到运行在yarn上的spark 集群 开始 Spark任务介绍 执行spark读取Hive中的一个表,这个表是用Hive来管理的HBASE表。统计这个表的总记录数。 具体代码如下: ...

1.基于Java代码自动提交Spark任务 SparkLauncher支持两种模式: (1).new SparkLauncher().launch(),直接启动一个Process,效果跟Spark submit提交一样 (2).new SparkLauncher().startApplicaiton(监听器) 返回一个...

Flink任务、Spark任务提交到集群,通常需要将可执行Jar上传到集群,手动执行任务提交指令,如果有配套的大数据平台则需要上传Jar,由调度系统进行任务提交。 对开发者来说,本地IDEA调试Flink、Spark任务不涉及对象...

通过spark-launcher提交 public void crateBatchTaskByLauncher() throws Exception { SparkApplicationParam sparkAppParams = new SparkApplicationParam(); sparkAppParams.setJarPath("/home/bd/SPARK/spark-...

1.场景在搭建好Hadoop+Spark环境后,现准备在此环境上提交简单的任务到Spark进行计算并输出结果。搭建过程:http://www.cnblogs.com/zengxiaoliang/p/6478859.html本人比较熟悉Java语言,现以Java的WordCount为例...

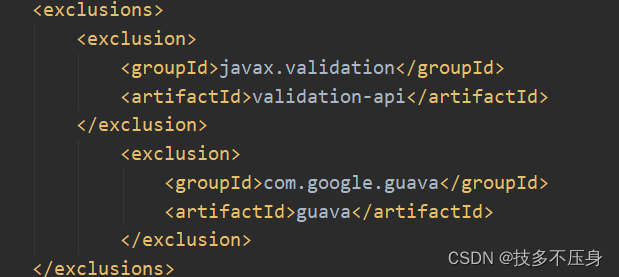

在网上查阅了很多资料,主要参考了以下两位大神的博客...首先spark jar要上传至hdfs中。pom文件中只需要依赖<dependency> ...

JAVA实现Spark的任务提交

三种方法作为记录: 1)直接调用SparkSubmit的main方法 ...SparkSubmit提交任务 String[] param = { "--class", "org.apache.spark.examples.SparkPi", "--master", "local[2]", "/bigdata/spark-2.

于是就想改在一下之前最丑陋的一个地方——任务提交本博客内容基于Spark2.2版本~在阅读文章并想实际操作前,请确保你有:一台配置好Spark和yarn的服务器支持正常spark-submit --master yarn xxxx的任务提交老版本老...

/bin/bashexport JAVA_HOME=/usr/java/jdk1.8.0_202export JRE_HOME=${JAVA_HOME}/jreexport CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/libexport PATH=${JAVA_HOME}/bin:$PATH#set hadoop envexport HADOOP_HOME.....

想通过java代码实现与使用spark-submit一样的效果,请问各位大佬应该怎么做? 望各位大佬不吝赐教!求教各位指点迷津!跪谢! 注:spark集群已经有3个spark-client;web项目开发使用的框架是springboot, web项目...

使用livy 提交spark任务时报错,错误信息:java.net.ConnectException: Call From dev-d-01.hz/10.192.168.62 to dev-d-02.hz:8032 failed on connection exception: java.net.ConnectException: Connection refused...

在利用spark-yarn jar包中的submitApplication方法将spark 任务远程提交到yarn 上的过程中,程序会将spark任务所用到的jar 包 上传至hdfs的某个暂存目录中。每次提交任务 ,程序都会将spark 用到的所有jar 包都上传...

一、向livy2提交spark自带例子 [root@ambari1 Test]# curl -X POST --data '{"file": "/home/Test/spark-examples_2.11-2.2.0.2.6.3.0-235.jar", "className": "org.apache.spark.examples.SparkPi","args":["100...

SparkConf conf = new SparkConf().setAppName... .set("spark.executor.memory", sparkConfig.getExecutorMemory()).set("spark.driver.host", sparkConfig.getDriverHost()) // 指定driver的hosts-name .se.

两种java方式的初步简介https://www.cnblogs.com/lyy-blog/p/8522616.html 主要针对new SparkLauncher().startApplicaiton(监听器)这种方式编码demohttps://...后面自己使用整理后继续补充~ ...

推荐文章

- Python菜鸟晋级04----raw_input() 与 input()的区别_pycharm没有raw input-程序员宅基地

- 高通AR增强现实多卡识别和扩展跟踪Unity_imagetarget扩展追踪-程序员宅基地

- 对于三星手机的手工root方法-程序员宅基地

- 2021年佛山高考成绩查询,2021年高三佛山一模,看佛山高中排名-程序员宅基地

- 删除并清空应收应付模块 期初数据_应付管理系统怎么清除数据-程序员宅基地

- 嵌入式固件加密的几种方式-程序员宅基地

- 非root情况下访问手机存储位置权限的方法_不root 通讯录 存放目录-程序员宅基地

- Mybatis项目开发流程_使用mybatis的开发步骤-程序员宅基地

- 三方协议,档案,工龄,保险,户口,-程序员宅基地

- 华为交换机命令 端口速率_华为S5700交换机的端口QOS限速问题-程序员宅基地