spark-sql_2.11-2.4.0-cdh6.1.1.jar

”spark-core_2.11-“ 的搜索结果

spark-core_2.11-2.0.0.jar比spark-core_2.11-1.5.2.jar少了org.apache.spark.Logging.class,故此把缺少的class放到spark-core_2.11-1.5.2.logging.jar里面

解决Spark升级到2.1后测试streaming-kafkaIDEA报java.lang.NoClassDefFoundError: org/apache/spark/Logging错误,将这个jar包放到spark的lib目录中,将这个jar包导进IDEA中的依赖,文档中除资源地址外,还有详细图解...

spark-core_2.11-1.6.0.jar spark-core_2.11-1.6.0.jar

Spark 项目 GraphX org.apache.spark/spark-graphx_2.11/2.3.1/spark-graphx_2.11-2.3.1.jar

Spark 项目 GraphX org.apache.spark/spark-graphx_2.11/1.2.1/spark-graphx_2.11-1.2.1.jar

本jar包用于驱动在Eclipse的scala程序,本机需要首先安装Scala即可使用

spark-core_2.11-2.1.3-SNAPSHOT.jar

Apache Spark - Apache HBase Connector 可以使用此jar包基于shc框架使用spark读写hbase

spark-core-2.11-1.6.1.jar,对应1.61版本的spark。欢迎下载~

未找到依赖项 'org.apache.spark:spark-hive_2.11:2.4.5' 找到对应的目录删除文件夹重新刷新导入即可 C:\Users\username\.m2\repository\org\apache\spark\spark-hive_2.11 总结 pom导入依赖错误就去对应文件夹...

spark所需jar包。spark所需jar包。spark所需jar包。spark所需jar包。spark所需jar包。

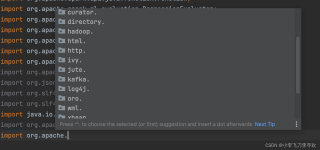

object DirectStream { def main(args: Array[String]): Unit = { //创建SparkConf,如果将任务提交到集群中,那么要去掉.setMaster("local[2]"... val conf = new SparkConf().setAppName("...

根据提供的引用内容,spark-core_2.11爆黄可能是由于版本不兼容或缺少依赖项导致的。如果您的项目中使用了不同版本的spark-core_2.11.jar文件,可能会导致冲突和错误。您可以尝试使用相同版本的spark-core_2.11.jar...

安装:spark 、kafka 就不说了! 第一个问题:到底选哪个 kafka 依赖包,打开网址:https://spark.apache.org/docs/2.1.3/streaming-kafka-integration.html 大体的意思有两个依赖包,这两个包怎么用 可以鼠标...

spark-core_2.11-1.6.0.jar spark-core_2.11-1.6.0.jar 相关下载链接://download.csdn.net/download/sysocc/10434000?utm_source=bbsseo

spark-core-2.11-1.6.1.jar,对应1.61版本的spark。欢迎下载~ 相关下载链接://download.csdn.net/download/w467502070/10680434?utm_source=bbsseo

presto-spark-core 是presto on spark需要的spark core的打包,源码地址:https://github.com/prestodb/presto-spark-core 核心其实就一个pom.xml 从这个pom.xml 可以看到presto 0.272 对应的spark 是2.0.2 ,scala ...

你可以尝试将该版本号改为一个已存在的版本号,或者检查你的仓库中是否有这个版本的 Spark Core 依赖。如果你想使用一个自定义版本的 Spark Core,你需要将它上传到你的私有仓库或者 Maven 中央仓库。

这是一个 Maven 坐标,表示 Apache Spark 的核心库,版本号为 2.4.5,使用的 Scala 版本是 2.11。如果你在使用 Maven 或 Gradle 等构建工具时遇到了这个错误,可能是因为你的配置文件中没有正确指定 Maven 仓库或者...

spark所需jar包。spark所需jar包。spark所需jar包。spark所需jar包。spark所需jar包。 相关下载链接://download.csdn.net/download/lg_696491/10136533?utm_source=bbsseo

spack,存储

文章目录RDD创建RDD的读取和存储driver和excutorRDD算子mapPartitionsWithIndex(func)算子glom算子takeOrdered算子RDD操作MYSQL查询操作插入操作 RDD创建 val conf : SparkConf = new SparkConf().setMaster(...

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">4.0.0...

推荐文章

- react常见面试题_recate面试-程序员宅基地

- 交叉编译jpeglib遇到的问题-程序员宅基地

- 【办公类-22-06】周计划系列(1)“信息窗” (2024年调整版本)-程序员宅基地

- SEO优化_百度seo resetful-程序员宅基地

- 回归预测 | Matlab实现HPO-ELM猎食者算法优化极限学习机的数据回归预测_猎食者优化算法-程序员宅基地

- 苹果发通谍拒绝“热更新”,中国程序猿“最受伤”-程序员宅基地

- 在VSCode中运行Jupyter Notebook_vscode jupyter notebook-程序员宅基地

- 老赵书托(2):计算机程序的构造与解释-程序员宅基地

- 图像处理之常见二值化方法汇总-程序员宅基地

- 基于springboot实现社区团购系统项目【项目源码+论文说明】计算机毕业设计-程序员宅基地