spark开发文档 spark开发文档 spark开发文档 spark开发文档 spark开发文档 spark开发文档

”spark-core“ 的搜索结果

spark-core-4ch-relay 这是通过 Web 面板控制带有 Spark Core 的 4 通道数字继电器的代码。 该项目是在 Chorispark 期间开发的,这是一个由 Wazzabi 在阿根廷布宜诺斯艾利斯举办的 Instructables Build Night,由...

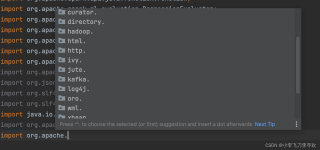

Spark-core核心部分的用Elipse IDE软件编写得内容

使用hortonworks的开源框架shc源码编译,适用于在cdh6.2.0环境下,pyspark2.4.0读写hbase2.1.0

Spark Core 全阶段目标 理解 Spark 的特点和作用 能够完成 Spark 的集群搭建和安装 通过入门案例理解 Spark 的编程模型 RDD 了解 RDD 的常见使用 1. Spark 概述 目标 Spark 是什么 Spark 的特点 Spark 生态圈的...

Spark 项目 GraphX org.apache.spark/spark-graphx_2.12/3.0.0/spark-graphx_2.12-3.0.0.jar

Spark 项目 GraphX org.apache.spark/spark-graphx_2.11/2.3.1/spark-graphx_2.11-2.3.1.jar

Spark 项目 GraphX org.apache.spark/spark-graphx_2.11/1.2.1/spark-graphx_2.11-1.2.1.jar

sparkshell脚本的作用:调用spark-submit脚本,并给spark-submit脚本 带上参数如下参数--classorg.apache.spark.repl.Main --name "Spark shell" "$@" 具体流程是:#1 捕获终端信号,执行退出...

SPARK-Core笔记

标签: spark

文章目录

一、Spark Core提供Spark最基础与最核心的功能,主要包括以下功能: (1)SparkContext: 通常而言,Driver Application的执行与输出都是通过SparkContext来完成的。在正式提交Application之前,首先需要初始化...

spark-core的入门案例

标签: spark

创建spark-core_2.11的maven工程所需的依赖 <dependencies> <dependency> <groupId>org.apache.spark</groupId> <artifactId>spark-core_2.11</artifactId> <version>...

动态资源分配。

spark所需jar包。spark所需jar包。spark所需jar包。spark所需jar包。spark所需jar包。

spark-core核心机制PPT讲解

任务申请的总core数为executor个数*单个executor的core数,如:申请4个executor,每个...一直以来,Spark只能设置固定的并行度(参考4),在大促期间,数据量激增,每个task处理的数量增加,很容易出现oom的情况。

关键字:spark-shell on yarn、spark-sql on yarn 前面的文章《Spark On Yarn...有时候在做开发测试的时候,需要使用spark-shell和spark-sql命令行,除了Local和Spark standalone模式,spark-shell和spark-sql也可以...

Spark-Shell操作 spark-shell简述 spark-shell是REPL(Read-Eval-Print Loop,交互式解释器),它为我们提供了交互式执行环境,表达式计算完成以后就会立即输出结果,而不必等到整个程序运行完毕,因此可以及时...

spark-samples-jeeconf-kyiv ... 3种兼容的实现基于:RDD(Spark Core),Data Frame DSL(Spark SQL),Data Frame SQL(Spark SQL) 序列化:默认Java和Kryo 如有任何疑问,请直接通过与我联系。

Spark零基础思维导图(内含spark-core ,spark-streaming,spark-sql),总结的很全面。 Spark零基础思维导图(内含spark-core ,spark-streaming,spark-sql)。 Spark零基础思维导图(内含spark-core ,spark-streaming,...

Spark-SQL教程

标签: spark

目录创建SparkSession通过SparkSession创建SparkContext手动创建DataFrame创建DataSetDataSet的使用 - 读取文本文件DataSet的使用 - 读取MySQLSpark_On_...Sql服务SPARK整合HIVESpark-Sqlspark-sql函数自定义函数

推荐文章

- react常见面试题_recate面试-程序员宅基地

- 交叉编译jpeglib遇到的问题-程序员宅基地

- 【办公类-22-06】周计划系列(1)“信息窗” (2024年调整版本)-程序员宅基地

- SEO优化_百度seo resetful-程序员宅基地

- 回归预测 | Matlab实现HPO-ELM猎食者算法优化极限学习机的数据回归预测_猎食者优化算法-程序员宅基地

- 苹果发通谍拒绝“热更新”,中国程序猿“最受伤”-程序员宅基地

- 在VSCode中运行Jupyter Notebook_vscode jupyter notebook-程序员宅基地

- 老赵书托(2):计算机程序的构造与解释-程序员宅基地

- 图像处理之常见二值化方法汇总-程序员宅基地

- 基于springboot实现社区团购系统项目【项目源码+论文说明】计算机毕业设计-程序员宅基地