”spark“ 的搜索结果

Spark SQL 可以通过 JDBC 从关系型数据库中读取数据的方式创建 DataFrame,通过对DataFrame 一系列的计算后,还可以将数据再写回关系型数据库中。如果使用 spark-shell 操作,可在启动 shell 时指定相关的数据库驱动...

Spark使用不同的数据源,Spark SQL开发,性能调优

FAILED: Execution Error, return code 30041 from org.apache.hadoop.hive.ql.exec.spark.SparkTask. Failed to create Spark client for Spark session xxx: java.util.concurrent.TimeoutException: Client 'xxx ...

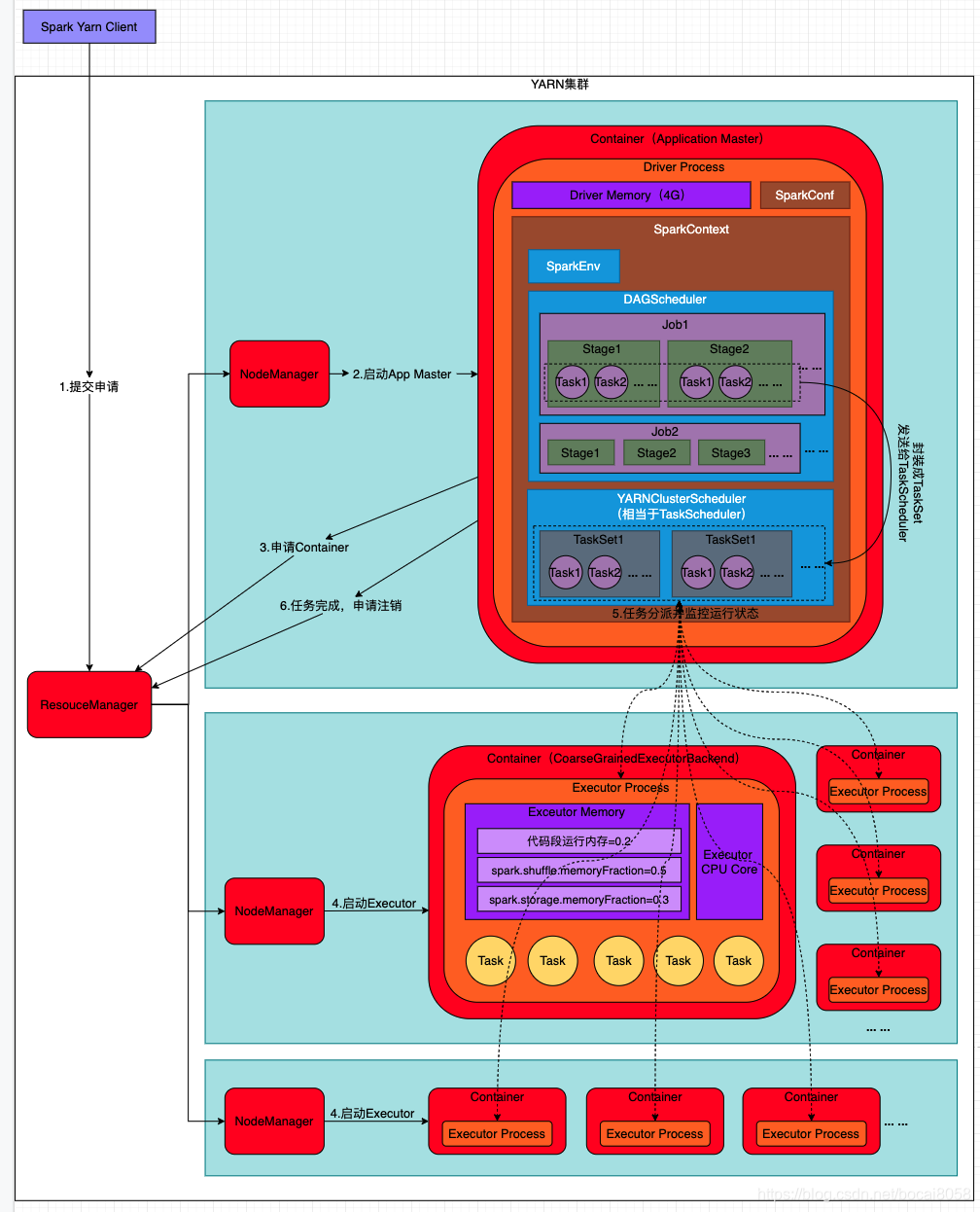

该文介绍了Spark的五种作业提交方式

2.关闭spark 进入以下目录:/usr/local/softwares/spark-2.3.2-bin-hadoop2.7/sbin 执行以下命令,关闭spark: ./stop-all.sh 3.关闭hadoop 进入以下目录:/usr/local/softwares/hadoop-2.7.2/sbin 执行以下...

基于Spark的电影推荐系统 本次项目是基于大数据过滤引擎的电影推荐系统--“懂你”电影网站,包含了爬虫、电影网站(前端和后端)、后台管理系统以及推荐系统(Spark)。 一、爬虫 开发环境:pycharm + python...

10.8.40.222 spark01 10.8.111.220 spark02 10.8.69.253 spark03 EOF # 配置SSH免密,主备master节点对所有worker节点免密,需要在3个节点执行: ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa ssh-copy-id spark01 ssh...

spark-shell1、概述2、启动 1、概述 \quad \quadSpark-shell 是 Spark 给我们提供的交互式命令窗口(类似于 Scala 的 REPL) 2、启动 直接启动bin目录下的spark-shell: ./spark-shell <1>直接使用 ./spark-...

本文仅列出了较大的区别点,实际mr与Spark为完全不同的大数据计算组件。 1.速度: MR与Spark的根本区别(关键优化)在于:Spark除了需要shuffle的计算,其他是将结果/中间结果持久化到内存中,而MR是都需要落地到...

Spark-SQL连接Hive 的五种方法

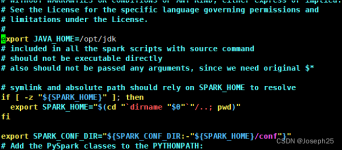

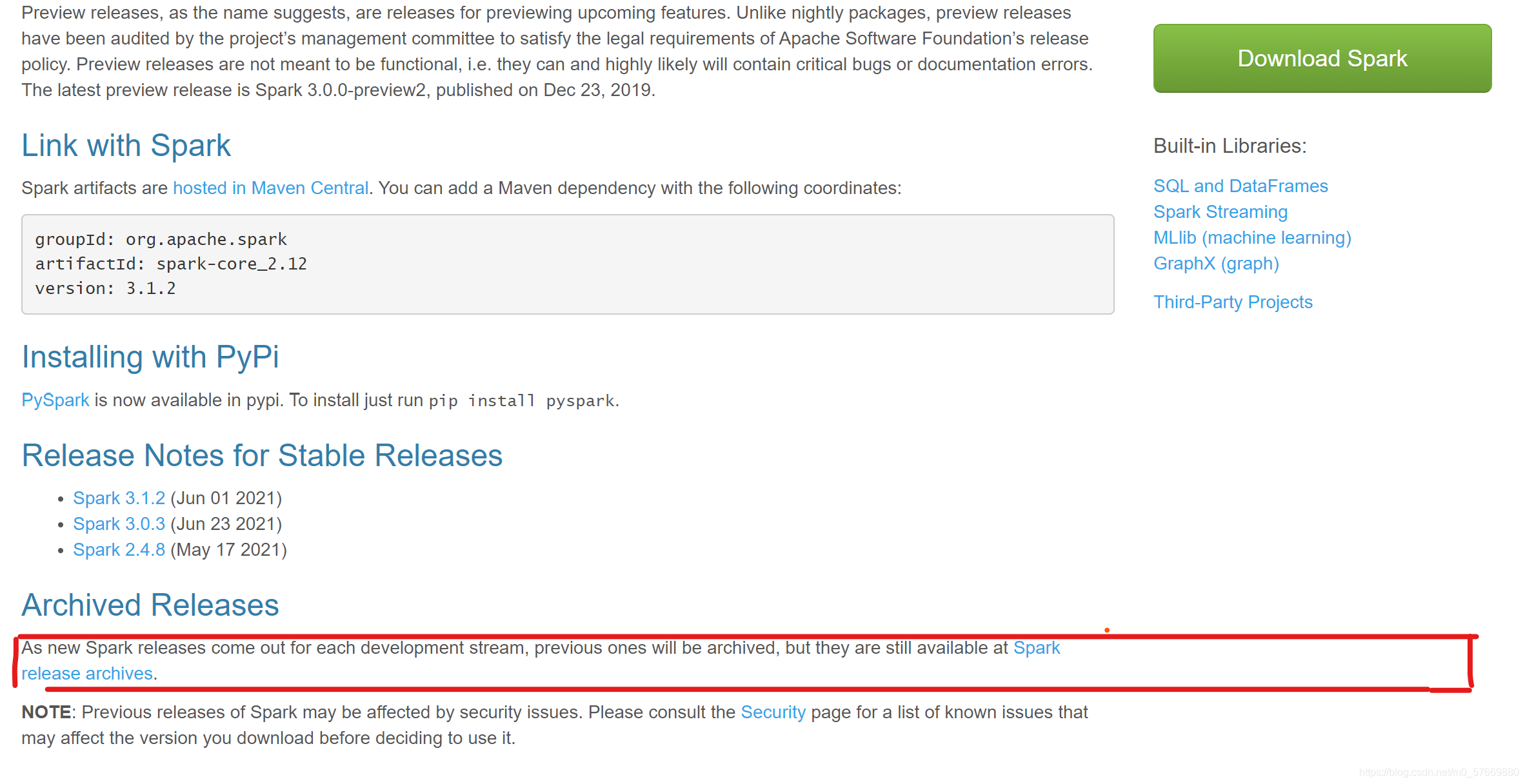

Spark的安装。Spark3.1.2的安装步骤。启动Spark集群。查看后台进程。查看Spark进程。通过Web界面访问Spark。验证Spark的安装是否成功。

spark 安装详细步骤

标签: spark

推荐文章

- python入门(13)异常与文件_except filenotfounderror:-程序员宅基地

- Android面试攻略_详细了解在当今的社会里android工程师应具备什么的技能?并能详细说说自己的见解。-程序员宅基地

- Zendframework 1.6整合Smarty_setting private or protected class member is not a-程序员宅基地

- Qt-装饰者模式_qt装饰模式-程序员宅基地

- 新开普掌上校园服务管理平台service.action RCE漏洞复现 [附POC]-程序员宅基地

- 基于 Milvus 的音频检索系统-程序员宅基地

- 331、基于51单片机智能红外遥控暖风机温度无线蓝牙远程控制系统设计(程序+原理图+配套资料等)_红外感应暖风机自动控制系统设计-程序员宅基地

- Android自定义圆角矩形图片ImageView_android 矩形圆角imageview-程序员宅基地

- 又见回文 字符串-程序员宅基地

- switch的参数可以是什么类型?_switch的参数有哪些-程序员宅基地