”seq2seq“ 的搜索结果

在训练时,解码器的输入是已知的目标序列(ground truth),而在推理阶段(生成阶段),解码器的输入是其自己先前生成的元素。这一层的输出将作为后续的输入提供给 GRU。它接受当前时刻的输入和先前时刻的隐藏状态,...

dynamic-seq2seq 欢迎关注我的另一个项目 基于中文语料和dynamic_rnn的seq2seq模型 Update: 修复loss计算bug 修复batch_size大于1时的计算bug Requirements tensorflow-1.4+ python2.7 (暂时未对python3 兼容) ...

Seq2Seq技术,全称Sequence to Sequence,该技术突破了传统的固定大小输入问题框架,开通了将经典深度神经网络模型(DNNs)运用于翻译与智能问答这一类序列型(Sequence Based,项目间有固定的先后关系)任务的先河...

文章目录EmbeddingWord Embedding词向量---One-HotOne-Hot骤如下:One-hot表示文本信息的缺点: Embedding Embedding能够用低维向量对物体进行编码还能保留其含义的特点非常适合深度学习。在传统机器学习模型...

手把手构建Seq2Seq模型!!!

rnn的matlab代码实现seq2seq-注意 介绍 该代码实现了RNN / LSTM / GRU seq2seq和seq2seq +注意模型,用于单词级的训练和采样。 您可以在Bot,自动文本摘要,机器翻译,问题解答系统等中应用它。在这里,我们向您展示...

Pytorch-seq2seq-光束搜索 带有注意力和贪婪搜索/波束搜索的Seq2Seq模型,用于在PyTorch中进行神经机器翻译。 此实现着重于以下功能: 用于其他项目的模块化结构 最少的代码以提高可读性 充分利用批处理和GPU。 ...

基于python的知识库的问答seq2seq模型代码实现

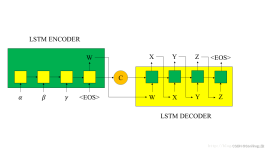

Seq2seq模型 当输入和输出都是不定长序列时,可以使⽤编码器—解码器(encoder-decoder) 或者seq2seq模型。这两个模型本质上都⽤到了两个循环神经⽹络,分别叫做编码器和解码器。编码器⽤来分析输⼊序列,解码器⽤...

使用PyTorch的Seq2Seq聊天机器人实现功能:Seq2Seq +光束搜索+ antiLM 要求 Python3 火炬0.3 语料库 用法 训练 python train . py 测试 python console python console . py . / ckpt model 光束搜索示例: me: ...

Seq2Seq-PyTorch 使用PyTorch的序列到序列实现安装克隆项目,进入项目目录并执行python setup.py install 或者pip install ./ 或简单地复制源代码。 推荐使用pip install ./ ,因为您可以先激活虚拟环境,然后再在该...

seq2seq 这是Tensorflow 2的seq2seq模型结构。 有三种模型架构,RNNSeq2Seq,RNNSeq2SeqWithAttention,TransformerSeq2Seq。 该存储库包含训练,评估,推断,转换为保存的模型格式脚本。 火车 例子 您可以通过运行...

PyTorch中的Seq2seq代码 根据和 数据预处理: 我使用以下步骤 > config/WMT14/download.sh # download WMT14 data into raw_data/WMT14 > config/WMT14/prepare.sh # preprocess the data, and copy the files to ...

seq2seq seq2seq-pytorch是一个框架,用于在实现的基于注意力的序列到序列模型。 该框架具有用于seq2seq模型,训练,推理,检查点等的模块化和可扩展组件。 介绍 Seq2seq将一个序列转换为另一序列。 它通过使用递归...

pytorch实现seq2seq和transformer字符级中英机器翻译,里面有一个小型中英的平行语料数据集和训练好的seq2seq的模型,transformer的模型需要自己训练

摘要聊天机器人是自然语言处理的一个重要的研究课题。本文梳理了生成式聊天机器人的构建步骤以及相关技术,对于相关的研究进行探讨。同时实际利用 tensorflow

matlab代码左移神经机器翻译(seq2seq)教程 作者:Thang Luong,Eugene Brevdo,赵瑞(,) 此版本的教程要求。 要使用稳定的TensorFlow版本,请考虑其他分支,例如。 如果您使用此代码库进行研究,请引用。 介绍 ...

您可能会在其他地方找到更好的seq2seq教程/实现。 seq2seq_chatbot 张量流中Seq2seq聊天机器人的实现。 特征 带智能加载程序的动态rnn (无填充) 预测中的波束搜索(全局最优快速近似) 解码器的信号指示器...

基于seq2seq+attention实现文本摘要任务——数据集基于seq2seq+attention实现文本摘要任务——数据集基于seq2seq+attention实现文本摘要任务——数据集基于seq2seq+attention实现文本摘要任务——数据集基于seq2seq+...

在PyTorch发行其1.0版本时,已经有很多基于PyTorch构建的出色的seq2seq学习包,例如OpenNMT,AllenNLP等。您可以从其源代码中学习。 用法:请注意有关注意力-RNN机器翻译的官方pytorch教程,除了此实现处理批处理...

深度学习入门-4(机器翻译,注意力机制和Seq2seq模型,Transformer)一、机器翻译1、机器翻译概念2、数据的处理3、机器翻译组成模块(1)Encoder-Decoder框架(编码器-解码器)(2)Sequence to Sequence模型(3)集...

【深度学习实战应用案例】时序分析-seq2seq(attention)(代码+数据)

迷你seq2seq 在PyTorch中注意神经机器翻译的最小Seq2Seq模型。 此实现重点在于以下功能: 用于其他项目的模块化结构 最少的代码可读性 充分利用批次和GPU。 此实现依赖于来最大程度地减少数据集管理和预处理部分...

matlab代码左移神经机器翻译(seq2seq)教程 作者:Thang Luong,Eugene Brevdo,赵瑞(,) 此版本的教程要求。 要使用稳定的TensorFlow版本,请考虑其他分支,例如。 如果您使用此代码库进行研究,请引用。 介绍 ...

RNN+Attention实现Seq2Seq中英文机器翻译

基于Seq2Seq注意力模型实现聊天机器人完整描述

压缩包包含训练好的模型,提供test.py脚本可直接使用,并提供可视化的输出。采用pytorch实现了简单法语-英语的翻译。模型采用attention-seq2seq,编码器和解码器采用gru实现。支持windows和linux操作系统。

注意力机制与Seq2seq模型;Transformer机器翻译及其相关技术编码器和解码器编码器解码器束搜索贪婪搜索束搜索注意力机制与Seq2Seq模型计算背景变量Transformer 机器翻译及其相关技术 机器翻译(MT):将一段文本从一...

推荐文章

- 大数据技术未来发展前景及趋势分析_大数据技术的发展方向-程序员宅基地

- Abaqus学习-初识Abaqus(悬臂梁)_abaqus悬臂梁-程序员宅基地

- 数据预处理--数据格式csv、arff等之间的转换_csv转arff文件-程序员宅基地

- c语言发送网络请求,如何使用C+发出HTTP请求?-程序员宅基地

- ccc计算机比赛如何报名,整理:加拿大的CCC是什么,怎么报名?-程序员宅基地

- RK3568 学习笔记 : ubuntu 20.04 下 Linux-SDK 镜像烧写_rk3568刷linux-程序员宅基地

- Gradle是什么_gradle是干嘛的-程序员宅基地

- adb命令集锦-程序员宅基地

- 【Java基础学习打卡15】分隔符、标识符与关键字_java分隔符有哪三种-程序员宅基地

- Python批量改变图片名字_python批量修改图片名称-程序员宅基地