import time import requests import pandas as pd ...# 通过地址获取经纬度 def address_to_coordinate(address): base = "http://apis.map.qq.com/ws/geocoder/v1/?address={}&key={}".format

”python获取header头内容“ 的搜索结果

把三个csv文件中的feature值整合到一个文件中,同时添加相应的label。 # -*-coding:utf-8 -*- import csv; label1 = '1' label2 = '2' label3 = '3' a = "feature1,feature2,feature3,feature4,feature5,...

使用xlrd和pandas来读取Excel中数据

python获取不同时区的时间:通过datetime获取UTC时间ISO格式 一个热点统计需求,需要限定一个时间范围,计算出该范围内的热点事件,相关数据则以UTC标准时间的ISO时间格式存在mongodb中,和服务器设置的时区UTC+8并...

今天分享下python如何处理在线处理数据。简单说下,实际情况要比这复杂的多的多。利用queue、threading多线程处理。如何拿到数据进行处理要根据实际情况来。 2、代码。 import sqlite3 import queue import ...

本篇文章主要介绍利用Python爬虫爬取付费文章,适合练习爬虫基础同学,文中描述和代码示例很详细,干货满满,感兴趣的小伙伴快来一起学习吧!

【python】爬取百度热搜排行榜Top50+可视化

框架整体使用Python3+Requests+Excel:包含对实时token的获取 1、——base ——-runmethond.py runmethond:对不同的请求方式进行封装 import json import requests requests.packages.urllib3.disable_warnings() ...

【代码】python读取excel任意一行数据。

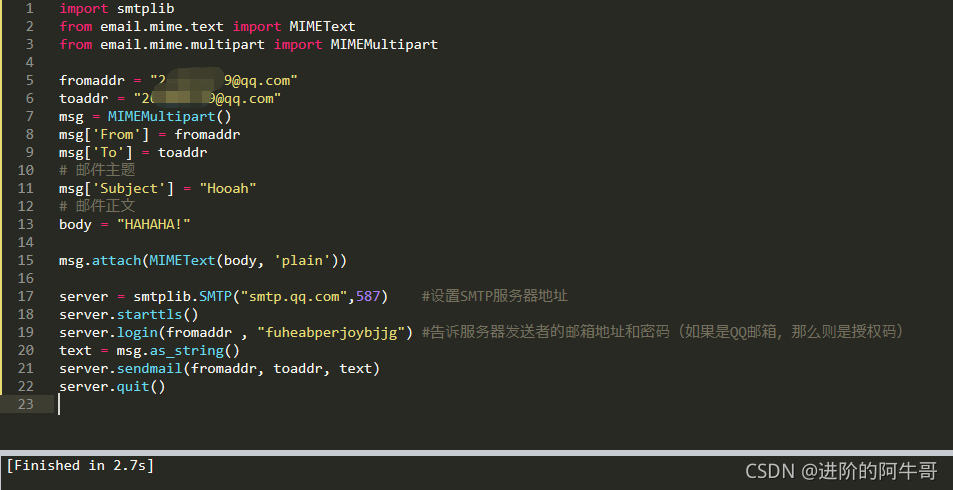

今天分享的文章主要讲解如何从邮件里面提取用户返回的线上问题内容并做解析,通过拿到的数据信息进行分析整理,然后进行封装请求禅道里的接口进行提交,提交请求过程中会对数据库中是否存在进行一次判断处

需要爬下新浪网上的有关关键字的新闻,把包含关键字的新闻内容查爬出来。 接下来就开始边做边记录下心得吧!!! 爬虫需要请求url,则需要导入requests包,要查找html页面里的内容,则需导入BeautifulSoup包 ...

具体操作是,首先在配置类中增加方法,从Header中取出数据,这里是取的“x-forwarded-for”的值,这是在nginx中设置到Header中的。具体代码如下: package com.donglake.booksnet.config; import ...

在学习 UA 伪装过后,我仍只知道如何通过 Python 爬虫访问某个网页,但如果我想获取百度翻译网站上某些具体内容又该如何操作呢?先打开百度翻译页面,只有某一块这才是我想要的内容,我想通过输入单词获得对应的翻译...

所需包: """ pip install eml_parser pip install langdetect """ import re import csv import os from bs4 import BeautifulSoup import eml_parser from langdetect import detect from langdetect import ...

通过urllib2包,根据url获取网页的html文本内容并返回 #coding:utf-8 import requests, json, time, re, os, sys, time import urllib2 #设置为utf-8模式 reload(sys) sys.setdefaultencoding( "ut...

python3,imap,pop3,邮件附件自动下载

python桌面翻译软件 本文任务是制作一个python桌面翻译小程序,主要内容是 (1)编写gui用户界面。 (2)利用爬虫的原理从在线翻译中抓取翻译结果。 (3)利用Pyinstaller将python...2)获取相应的内容:如果服务器能正

Python 爬取网页表格中的数据,并对解析错误的数据进行修复处理。 用到的库:Requests,BeautifulSoup,Pandas.

1. 问题背景在使用urllib2 module抓取web数据时,如果希望使用如何request header,减少传输时数据量。返回的数据,是经过gzip压缩的。直接按照 content.decode(“utf8”), 解码会出现异常,并且也无法检测网页数据...

推荐文章

- Ubuntu/linux下下载工具_ubuntu下载软件助手 linux版本-程序员宅基地

- HTML、JSP前端页面国际化(i18n)_html全局国际化-程序员宅基地

- Python高级-08-正则表达式_写出能够匹配只有下划线和数字还有字母组成(且第一个字符必须为字母)的163邮箱(@1-程序员宅基地

- 寻仙手游维护公告服务器停服更新,寻仙手游2月1日停服更新公告 2月1日更新了什么...-程序员宅基地

- 用python自动预约图书馆座位_微信图书馆座位秒抢脚本-程序员宅基地

- Android真机或模拟器激活Xposed框架的方法_de.robv.android.xposed.installer-程序员宅基地

- 操作系统为什么要分用户态和内核态_用户态和内核态都需要cpu参与,为什么要区分-程序员宅基地

- 01—JVM与Java体系结构(简单介绍)_01_jvm与java体系结构.pptx-程序员宅基地

- 国有建筑企业数字化转型整体解决方案_建筑企业数字化转型行动方案-程序员宅基地

- 性能测试的软件------loadrunner_loadrunner有有三个图标,-程序员宅基地