Hive 使用datediff函数求两个指定日期的差datediff(endDate, startDate)datediff(datepart,startdate,enddate)不支持hive datediff(endDate, startDate) datediff(endDate, startDate) - Returns the number of days...

”hive使用“ 的搜索结果

输入用户名和密码,用户名必须为root,密码任意。

Hive

0.7版本后Hive开始支持任务执行选择本地模式(local mode)。大多数的Hadoop job是需要hadoop提供的完整的可扩展性来处理大数据的。不过,有时hive的输入数据量是非常小的。在这种情况下,为查询出发执行任务的时间...

hive入门以及dbeaver连接hive

它可以将结构化的数据文件映射为一张数据库表,并提供类似SQL的查询语言(HiveQL),使用户能够使用SQL语句来查询、汇总和整理大规模的数据集。Hive的核心功能包括数据存储、数据查询、数据处理、数据转换以及数据...

当Hive提供的内置函数无法满足你的业务处理需要时,此时就可以考虑使用用户自定义函数参考官方文档UDF一进一出,单行函数UDAF用户自定义聚合函数,多进一出。UDTF用户自定义表生成函数,一进多出。

Hive 默认使用 derby 作为映射表(SQL 操作映射为MapReduce Job,将SQL中创建的表映射为 hdfs 的文件/文件夹,字段映射为其中的行),但 derby 的一大缺陷在于它不允许多个客户端同时执行sql操作(可能新版本的hive...

说下为什么要使用Hive?Hive的优缺点?Hive的作用是什么?

【代码】【JDBC-Hive】使用JDBC操作Hive数据库_jdbc操作hive到本地。

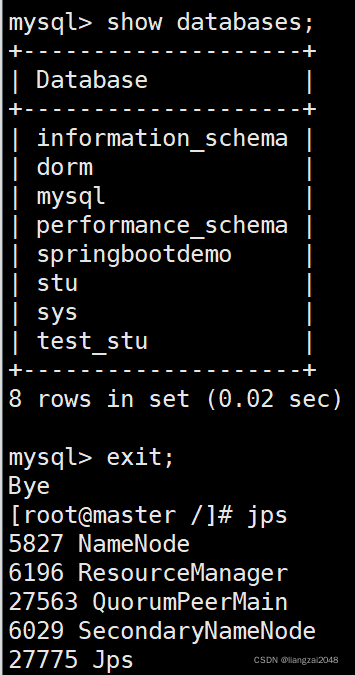

进mysql 删除元数据数据库 重新创建一下 退出mysql

1.split的字段串是空串(a='') size(split(a,','))=1 2.split的字段串是null(a is null) size(split(a,','))=-1

hive默认使用分隔符如空格,分号,"|",制表符\t来格式化数据记录,对于复杂数据类型如json,nginx日志等,就没有办法拆分了,这时候需要更加强大的SerDe来处理复杂数据,如使用JsonSerDe或者使用正则...

步骤一:基础环境和安装准备 Hive 组件需要基于 Hadoop 系统进行安装。因此,在安装 Hive 组件前,需要确保 Hadoop 系统能够正常运行。本章节内容是基于之前已部署完毕的 Hadoop 全分布系统,在 master 节点上实现 ...

metatool 使用说明。

&...因为hive是批处理系统,所以hive提供了一个动态分区功能,其可以基于查询参数的位置去推断分区的名称,从而建立分区。   1.创建一个单一字段分区表hive> create t...

spark 调用sql插入hive 失败 ,执行语句如下 spark.sql("INSERT INTO default.test_table_partition partition(province,city) SELECT xxx,xxx md5(province),md5(city) FROM test_table") 报错如下,需动态插入...

*

随机数:ceil(rand*10)

内置的HASH()函数使用哪种哈希算法? 我理想地是在寻找SHA512/SHA256哈希...HASH函数(从Hive 0.11开始)使用类似于java.util.List#hashCode的算法。 其代码如下所示: int hashCode = 0; // Hive HASH uses 0 as the s...

Hive语法中with as的使用一、with as是什么?二、with as怎么用?三、with as测试三、with as总结 一、with as是什么? 如果有一个需求,或者一堆需求,而这一堆需求中频繁的都要使用一个数据集,但是这个数据集在...

1.1. hive错误 1.1.1. hive2.3初始化mysql不起作用 [root@localhost65bin]# schematool -initSchema -dbType mysql--verbose Metastore connectionURL: jdbc:derby:;databaseName=metastore_db;create=true ...

一、hive提供了jdbc的连接方式,就是在hive的某个计算节点开启hiveserver2启动方法如下 默认已启动hadoop 先启动hive元数据服务 hive --service metastore & 再启动hiveserver2服务 hive--...

union all 用来合并多个select的查询结果,需要保证select中字段须一致,每个select语句返回的列的数量和名字必须一样,否则,一个语法错误会被抛出。 更多内容可参考:......

使用sqoop将mysql数据导入至hive的本质,其实是数据先导入至hdfs,然后会有一个脚本去执行将hdfs的数据load至hive中。所以我们将数据导入到hive时,其实hdfs中也会有这个数据。 使用sqoop将数据导入至hive时,需要...

推荐文章

- confluence搭建部署_ata confluence-程序员宅基地

- SpringCloud与SpringBoot版本对应关系_springboot 2.1.1 对于的cloud-程序员宅基地

- 如何恢复硬盘数据?简单解决问题_磁盘恢复 csdn-程序员宅基地

- 苹果手机测试网络速度的软件,App Store 上的“网速测试大师-测网速首选”-程序员宅基地

- 教了一年少儿编程,说说感想和体验-程序员宅基地

- 22东华大学计算机专硕854考研上岸实录-程序员宅基地

- 如何用《玉树芝兰》入门数据科学?-程序员宅基地

- macOS使用brew包管理器_brew清理缓存-程序员宅基地

- 【echarts没有刷新】用按钮切换echarts图表的时候,该消失的图表还在,加个key属性就解决了_echarts 怎么加key值-程序员宅基地

- 常用机器学习的模型和算法_常见机器学习模型算法整理和对应超参数表格整理-程序员宅基地