”gru“ 的搜索结果

cnocr-v2.3-densenet-lite-136-gru-epoch=004-ft-model.onnx

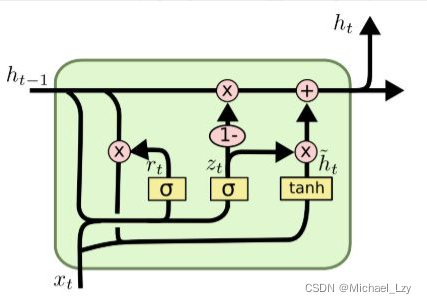

GRU实验效果与LSTM相似,但是更易于计算。为控制更新的门控(update gate)。控制重置的门控(reset gate),GRU通过输入来获取两个门控状态。当使用sigmoid作为激活函数。为传递给下一个节点的隐状态。为当前隐藏...

其效果与LSTM(1997年提出)相近,但是相对于LSTM,GRU的参数更加少,更加方便计算。约接近于1的时候,记忆下来的数据将越多,如果越接近于0,则代表以往的越多。总的来说,这一步骤的操作就是忘记上一个时刻隐藏...

3 将最有优的预测方案与其他方法进行比较,显示出其构建模型的优越性,例如最终,注意力机制的gru神经网络与lstm、svr、神经网络进行比较,得出注意力机制的GRU神经网络效果最好 4参与比较的模型其预测结果要以图的...

最终的输出是两个GRU的输出拼接,这可以利用输入序列的双向信息。GRU与LSTM的主要区别在于GRU没有细胞状态和忘记门,它合并了LSTM的输入门和遗忘门,并没有输出门,这使得GRU的结构更简单。GRU通过门机制可以选择性地...

【循环神经网络系列】三、GRU

标签: 深度学习

GRU

不同于LSTM的三个门控单元,GRU中只有两个(将输入门和输出门合并为一个更新门),简化了计算。但是对于大数据集的情况下,LSTM比GRU性能更好,而总体而言差不多在GRU中重置门有助于捕获序列中的短期依赖关系更新门...

GRU时间序列预测(Python完整源码和数据) GRU时间序列预测(Python完整源码和数据) GRU门控循环单元时间序列预测,AQI预测(Python完整源码和数据)

1.MATLAB实现EEMD-GRU、GRU时间序列预测对比; 2.时间序列预测 就是先eemd把原输入全分解变成很多维作为输入 , 再输入GRU预测 ; 3.运行环境Matlab2020b及以上,输出RMSE、MAPE、MAE等多指标对比, 先运行main1_eemd_...

注意-GRU-3M 论文“具有自适应Attention-GRU模型的品牌级排名系统[C]”的代码。 (接受IJCAI 2018) 运行命令:python train.py --buckets“ ./data/” --checkpointDir ./log/ --exp debug --m1 1 --m2 0 --m3 1 ...

PSO优化GRU-LSTM超参数 1、摘要 本文主要讲解:使用PSO优化GRU-LSTM超参数,神经元个数、学习率、dropout和batch_size 主要思路: 建立GRU-LSTM模型 定义PSO的参数:最大迭代次数、最大惯性权重、最小惯性权重、...

GRU门控循环单元时间序列预测(MATLAB完整源码和数据) GRU门控循环单元时间序列预测(MATLAB完整源码和数据) GRU门控循环单元时间序列预测(MATLAB完整源码和数据) GRU门控循环单元时间序列预测,运行版本Matlab...

GRU4REC-PyTorch GRU4REC模型的PyTorch实现。 原始论文: 对原始论文的扩展: 这个代码是基于由Younghun宋(YHS-968),并实现 此版本支持TOP1,BPR,TOP1-max,BPR-max和交叉熵损失。 要求 PyTorch 0.4.1 的...

利用GRU模型预测短时客流(时间序列预测),以发现时间序列变量趋势

GRU-ARIMA时间序列预测 GRU和ARIMA模型用于时间序列预测,其中GRU可用于短期和长期预测。使用GRU和ARIMA模型进行时间序列预测,其中GRU可以进行短期预测和长期预测。

资源内容:基于LSTM、GRU、BiLSTM预测股票价格比较的Python仿真(完整源码+说明文档+数据).rar 代码特点:参数化编程、参数可方便更改、代码编程思路清晰、注释明细。 适用对象:工科生、数学专业、算法等方向学习...

基于鲸鱼算法优化门控循环单元结合注意力机制WOA-GRU-Attention回归预测,多变量输入模型。matlab代码,2021b版本及以上。 优化参数:隐含层节点,学习率,正则化。 评价指标包括:R2、MAE、MSE、RMSE和MAPE等,...

MATLAB实现CNN-GRU卷积门控循环单元多输入时序预测(完整源码和数据) 数据为多变量时间序列数据,多输入单输出 运行环境MATLAB2020b及以上,运行程序即可。

基于卷积门控循环单元结合注意力机制(CNN-GRU-Attention)时间序列预测(Matlab完整源码和数据) 基于卷积神经网路-门控循环单元结合SE注意力机制的时间序列预测 单输出单输出,时间序列预测。 运行环境Matlab2021及...

基于attention文本分类代码基于attention文本分类代码基于attention文本分类代码

时间序列预测,利用GRU模型预测客流、车流时间序列

基于VMD-SSA-GRU、VMD-GRU、GRU的多变量时间序列预测(Matlab完整程序和数据) 变分模态分解结合麻雀算法优化门控循环单元 1.先运行vmdtest,进行vmd分解; 2.再运行VMD-SSA-GRU,三个模型对比;

Matlab实现SSA-CNN-GRU麻雀算法优化门控循环单元多输入单输出回归预测(完整源码和数据) 1.Matlab实现SSA-CNN-GRU麻雀算法优化卷积门控循环单元(CNN-GRU)多输入单输出回归预测(完整源码和数据) 2.输入多个特征,...

基于贝叶斯算法(bayes)优化卷积神经网络-门控循环单元(CNN-GRU)时间序列预测,单列数据集,Matlab完整程序 评价指标包括:R2、MAE、MSE、RMSE等,代码质量极高, 方便学习和替换数据。 运行环境matlab2020及以上。

MATLAB实现GRU门控循环单元多输入多输出预测(完整源码和数据) 数据为多输入多输出预测数据,输入10个特征,输出3个变量,程序乱码是由于版本不一致导致,可以用记事本打开复制到你的文件。 运行环境MATLAB2020b及...

推荐文章

- Unity3D 导入资源_unity怎么导入压缩包-程序员宅基地

- jqgrid 服务器端验证,javascript – jqgrid服务器端错误消息/验证处理-程序员宅基地

- 白山头讲PV: 用calibre进行layout之间的比对-程序员宅基地

- java exit方法_Java:如何测试调用System.exit()的方法?-程序员宅基地

- 如何在金山云上部署高可用Oracle数据库服务_rman target sys/holyp#ssw0rd2024@gdcamspri auxilia-程序员宅基地

- Spring整合Activemq-程序员宅基地

- 语义分割入门的总结-程序员宅基地

- SpringBoot实践(三十五):JVM信息分析_怎样查看springboot项目的jvm状态-程序员宅基地

- 基于springboot+vue的戒毒所人员管理系统 毕业设计-附源码251514_戒毒所管理系统-程序员宅基地

- 【LeetCode】面试题57 - II. 和为s的连续正数序列_leet code 和为s的正数序列 java-程序员宅基地