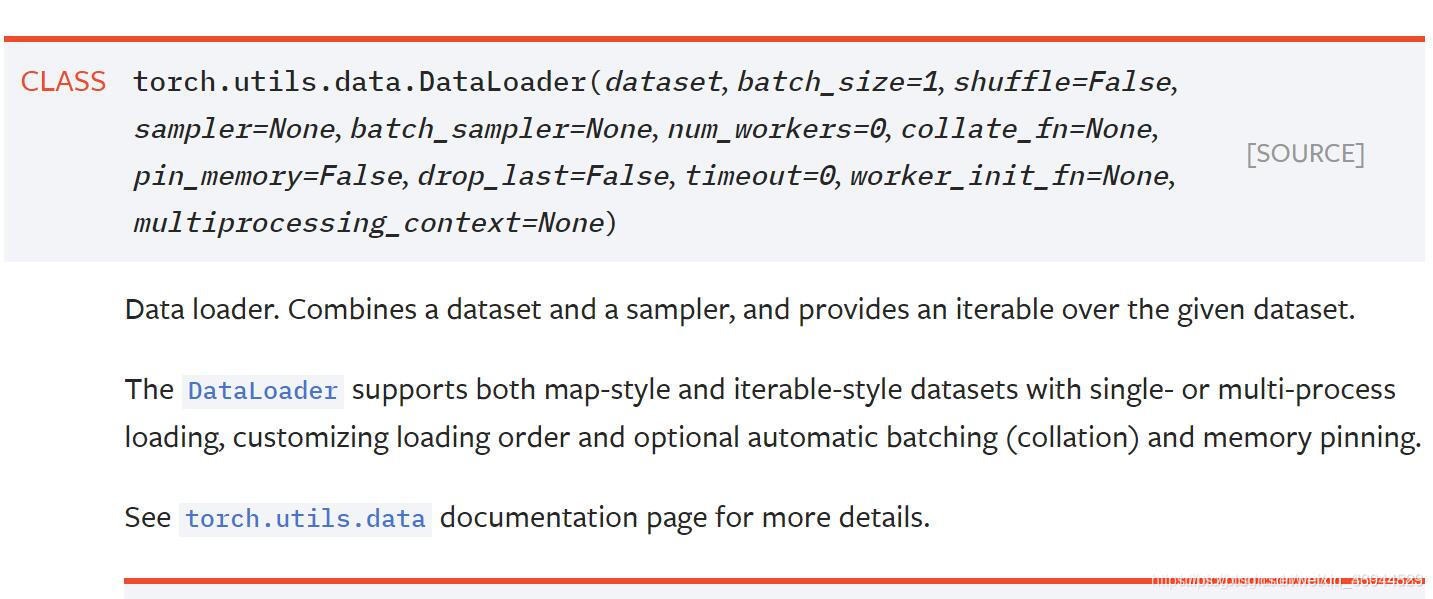

iteration:1个iteration即迭代一次,也就是用batchsize个样本训练一次。 epoch:1个epoch指用训练集中的全部样本训练一次,此时相当于batchsize 等于训练集的样本数。 Dataloader参数详解 dataset(Da

”batch_size“ 的搜索结果

(3)mini-batch梯度下降法:为了每次训练尽可能的多输入一些样本,同时又不会太耗时和超内存,mini-batch将训练样本分为多个批次,一个一个的输入,最后将多个输入的结果进行平均,即得到一次完整训练的梯度。

1、epoch Keras官方文档中给出的解释是:“简单说,epochs指的就是训练过程接中数据将被“轮”多少次” (1)释义: 训练过程中当一个完整的数据集通过了神经网络一次并且返回了一次,这个过程称为一个epoch,网络会...

个人理解,在test的时候,batchsize不会对测试结果产生影响,有很多人在test的时候都是不设batchsize的,直接读进去。 至于valid,个人认为,只要用了model.eval(),batchsize也不会影响结果。Bachnormalize虽然会带...

forvalidation_batch_sizeandtest_batch_size, you should pick the largest batch size that your hardware can handle without running out of memory and crashing.Finding this is usually a simple trial and e...

epoch,batch_size,iterations,学习率,这几个都是深度学习训练模型时经常遇到的概念,这几个都是什么呢? 梯度下降法 一切的一切,要从机器学习中的梯度下降法说起。梯度下降法是机器学习中经典的优化算法之一,...

batch_size 机器学习使用训练数据进行学习,针对训练数据计算损失函数的值,找出使该值尽可能小的参数。但当训练数据量非常大,这种情况下以全部数据为对象计算损失函数是不现实的。因此,我们从全部数据中选出一...

GPU显存、规格指标;神经网络训练,显存占用

梯度下降 这是一个在机器学习中用于寻找最佳结果...在数据很庞大的时候(在机器学习中,几乎任何时候都是),我们才需要使用 epochs,batch size,迭代这些术语,在这种情况下,一次性将数据输入计算机是不可能的...

随机梯度下降SGD中有一个重要的超参数batch_size(批量大小),其大小对整个模型训练的影响总结如下: 1.更大的批量会计算更计算更精确的梯度估计,但是回报是小于线性地。 因为每次参数更新所用到的数据越多,...

谈谈深度学习中的 Batch_Size Batch_Size(批尺寸)是机器学习中一个重要参数,涉及诸多矛盾,下面逐一展开。 首先,为什么需要有 Batch_Size 这个参数? Batch 的选择,首先决定的是下降的方向。如果数据集比较...

日志是一个十分必要的操作,有助于后期分析实验结果,特别是在多台不同环境下训练,为了区分,还是十分有必要记录相关平台信息的,比如 hostname,Python版本信息,Pytorch版本信息等!查看显卡信息 首先需要获取...

nnunet修改batchsize、patchsize 本文只是为了自己平时训练方便而做的笔记,不保证一定正确,但这样修改的确能正常使用。 1、首先使用官方的数据集处理命令,对数据集进行处理 2、使用如下代码修改batchszie、...

文章目录1. 获取和读取数据2. 初始化模型参数3. 实现softmax运算4. 定义模型5. 定义损失函数6. 计算分类准确率7. 训练模型8....这一节我们来动手实现softmax回归。首先导入本节实现所需的包或模块。...

梯度累加其实是为了变相扩大batch_size,用来解决显存受限问题。有牛x的显卡就不用考虑这骚操作。

hibernate.jdbc.batch_size 25 这两个选项非常非常非常重要!!!将严重影响Hibernate的CRUD性能! C = create, R = read, U = update, D = delete Fetch Size 是设定JDBC的Statement读取...

batch_size是机器学习的一个重要参数,为了在内存效率和内存容量之间寻找最佳平衡。在学习Word_Embedding时,vocabulary_size = 10000, 隐层神经元个数为300,即embedding_size = 300,在做神经网络训练时,考虑到...

通过batch_size来控制,将train_data划分成子集,每个子集都有batch_size和样本,作为一个batch。 batch_size越大,训练速度越快,对显卡的要求就越高。 如果batch_size过小,训练数据就会非常难收敛,导致欠拟合 ...

NLP 一个句子:一个sample 一个句子由n个词:n个timestep 一个词是k维的词向量:k个feature ...时间序列是一个n行m列的excel表 ...n行:共有n个观察记录,每个时间点一次(6点、7点、8点....... m列:每一条观察记录,...

在说batch_sampler之前,这里不要脸的放一下之前关于dataset和dataloader的博客 正文 我在下面的代码中第一次看到了batch_sampler,于是好奇去看看这个FixedLengthBatchSampler到底在干嘛。 iter(self) 首先它放到...

batch-size是深度学习模型在训练过程中一次性输入给模型的样本数量。它在训练过程中具有重要的意义,影响着训练速度、内存使用以及模型的稳定性等方面。以下是batch-size训练速度:较大的batch-size通常可以加快训练...

epoch、iteration、bath_size、episode在DNN中的解释: epoch one forward pass and one backward pass of all the training examples, in the neural network terminology,重点就是所有的训练数据都要跑一遍。假设...

推荐文章

- react常见面试题_recate面试-程序员宅基地

- 交叉编译jpeglib遇到的问题-程序员宅基地

- 【办公类-22-06】周计划系列(1)“信息窗” (2024年调整版本)-程序员宅基地

- SEO优化_百度seo resetful-程序员宅基地

- 回归预测 | Matlab实现HPO-ELM猎食者算法优化极限学习机的数据回归预测_猎食者优化算法-程序员宅基地

- 苹果发通谍拒绝“热更新”,中国程序猿“最受伤”-程序员宅基地

- 在VSCode中运行Jupyter Notebook_vscode jupyter notebook-程序员宅基地

- 老赵书托(2):计算机程序的构造与解释-程序员宅基地

- 图像处理之常见二值化方法汇总-程序员宅基地

- 基于springboot实现社区团购系统项目【项目源码+论文说明】计算机毕业设计-程序员宅基地