”Spark环境搭建“ 的搜索结果

环境搭建 Spark On Yarn Hadoop环境 设置CentOS进程数和文件数(重启生效) [root@CentOS ~]# vi /etc/security/limits.conf * soft nofile 204800 * hard nofile 204800 * soft nproc 204800 * hard nproc 204800 ...

spark学习 spark开发环境搭建spark学习 spark开发环境搭建spark学习 spark开发环境搭建spark学习 spark开发环境搭建

由于文案过于长,在此就不一一介绍了,这份Java后端架构进阶笔记内容包括:Java集合,JVM、Java并发、微服务、SpringNetty与 RPC 、网络、日志 、Zookeeper 、Kafka 、RabbitMQ 、Hbase 、MongoDB、Cassandra 、Java...

适用于学者

本文讲解如何在Linux系统中安装Spark并配置Spark环境,以及Spark的基本使用方法。

如果你看了这篇博客没有装好Spark,你来找我!!!! 首先Spark是一个基于内存的用于大规模数据...最后Spark可以运行在Hadoop、Apache Mesos,Kubernetes等环境、也可以进行独立或者在云上运行,它可以访问各种资源。

Spark是一个开源的大数据处理框架,它提供了一个快速、通用和易于使用的计算引擎。Spark最初由美国加州伯克利大学AMP实验室于2009年开发,是基于内存计算的大数据并行计算框架,可用于构建大型的、低延迟的数据分析...

现在,SSH服务器应该能够正常启动,并且你应该能够从远程系统连接到你的Alpine Linux容器。你可以使用文本编辑器(如vi或nano)打开该文件并进行编辑。:一旦安装了OpenSSH服务器,你需要配置它以允许远程连接。...

打开Dependencies勾选上scala与jars即可。选择Libraries 新加java项目。按住alt+ctrl+shift+s。打开设置,下载扩展scala。设置完成后选择Modules。

Spark环境搭建教程

标签: spark

Spark环境搭建 Spark Local本地模式 Standalone-独立集群 Standalone-HA Spark-On-Yarn Spark 是一种基于内存的快速、通用、可扩展的大数据分析计算引擎

linux端的hadoop和spark环境搭建: Linux环境设置 1设置固定IP(静态) 2新增oracle用户 3设置oracle用户拥有root用户的命令 4设置网络映射 5关闭防火墙 vim /etc/sysconfig/network-scripts/ifcfg-eth0 DEVICE=eth0...

配置内容:(添加到末尾处,也可也直接输入。压缩包解压,解压后重命名。提示:启动后不要关闭。

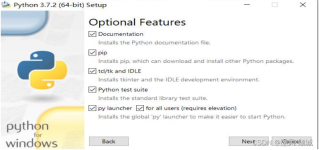

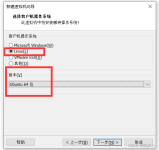

1)安装软件清单如下:参见: Windows环境下配置Spark3.0.0_QYHuiiQ的博客-程序员宅基地

本文主要介绍Spark相关环境搭建

hadoop,spark

3) 、ResourceManager接到ApplicationMaster的资源申请后会分配Container,然后ApplicationMaster在资源分配...3.需要被提交的代码程序:,或我们后续自己开发的Spark任务。真正干活的Executor运行在YARN提供的容器内。

一、Java安装1、安装目录准备在安装这些包之前在家目录下创建一个app的目录,app目录中创建一个tmp目录:[root@hadoop-master ~]#mkdir -p app/tmp2、解压JDK上传JDK1.8版本jdk-8u74-linux-x64.tar.gz到linux上,...

这篇博客,Alice为大家带来的是Spark集群环境搭建之——standalone集群模式。 文章目录集群角色介绍集群规划修改配置并分发启动和停止查看web界面测试 集群角色介绍 Spark是基于内存计算的大数据并行计算框架,...

Spark环境搭建-Linux

本篇博客,Alice为大家带来关于如何搭建Spark的on yarn集群模式的教程。 文章目录准备工作cluster模式client模式[了解]两种模式的区别 官方文档: http://spark.apache.org/docs/latest/running-on-yarn.html 准备...

【代码】Spark环境搭建与使用。

本篇博客,Alice为大家带来的是Spark的HA高可用环境搭建的教程。 原理 Spark Standalone集群是Master-Slaves架构的集群模式,和大部分的Master-Slaves结构集群一样,存在着Master单点故障的问题。 如何解决这个单点...

推荐文章

- 『Android 技能篇』优雅的转场动画之 Transition-程序员宅基地

- Webshell绕过技巧分析之-base64编码和压缩编码-程序员宅基地

- 大一计算机思维知识点,大学计算机—基于计算思维知识点详解.docx-程序员宅基地

- 关于敏捷开发的一篇访谈录-程序员宅基地

- 挑战安卓和iOS!刚刚,华为官宣鸿蒙手机版,P40搭载演示曝光!高管现场表态:我们准备好了...-程序员宅基地

- 精选了20个Python实战项目(附源码),拿走就用!-程序员宅基地

- android在线图标生成工具,图标在线生成工具Android Asset Studio的使用-程序员宅基地

- android 无限轮播的广告位_轮播广告位-程序员宅基地

- echart省会流向图(物流运输、地图)_java+echart地图+物流跟踪-程序员宅基地

- Ceph源码解析:读写流程_ceph 发送数据到其他副本的源码-程序员宅基地