”SNPE“ 的搜索结果

snpe后量化手册

snpe-码头工人 Docker容器和帮助程序为snx模型转换和基准测试构建snpe 1.47。 大多数示例都假定您正在使用视觉模型,但是它们仍然可以帮助您完成当前的任务。 构建Docker容器 首先下载并将其放置在该项目的根目录中...

snpe游乐场 conda创建--name snpe python = 3.5 conda激活snpe 下载模型并准备资产 资产目录包含网络模型资产。 如果先前已下载资产,则将ASSETS_DIR设置到此目录,否则选择目标目录以在下载资产时存储它们。 如果...

yolov8转snpe时Concat报错问题解决方法

高性能计算(High performance computing, 缩写HPC)指通常使用很多处理器(作为单个机器的一部分)或者某一集群中组织的几台计算机(作为单个计 算资源操作)的计算系统和环境。有许多类型的HPC 系统,其范围从标准...

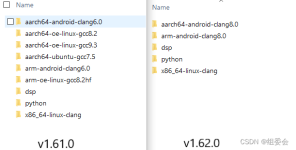

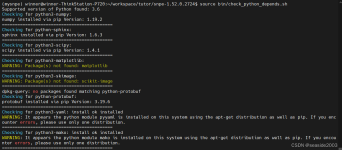

查看版本所需的python版本:snpe-1.55.0.2958/doc/html/setup.html。6. bin目录下执行如下操作:snpe-onnx-to-dlc -i xxx.onnx。注册高通的邮箱不要使用qq邮箱,最好是使用公司邮箱。5. cd ./bin目录。

snpe-1.50.0.zip

SNPE上带有MobileNet-SSD的演示APP。 兼容于 (GPU加速)QRD 8998,QRD 710,Galaxy S8 / S8 +,Galaxy S9 (仅限CPU)Pixel,Pixel 2,HTC One M8 可以在任何Android M +手机上使用。 此版本不提供DSP加速功能,...

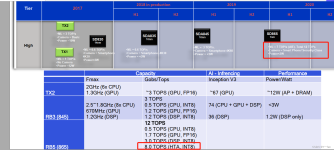

首先贴出高通SNPE SDK最新版的下载地址: https://developer.qualcomm.com/software/qualcomm-neural-processing-sdk 以下吐槽全部基于当前时间段(2019.07 ~ 2019.08)下载的SNPE-1.27.1.382版本为基准,对后续...

说明文档在 {}/SNPE/2.15.0.230926/docs/SNPE/html/index.html 中。解压.qik 文件 , 执行命令解压/opt/qcom/qik3/bin/qik。windows版的直接下载安装就行了。找到对应的linux版本,安装QPM。

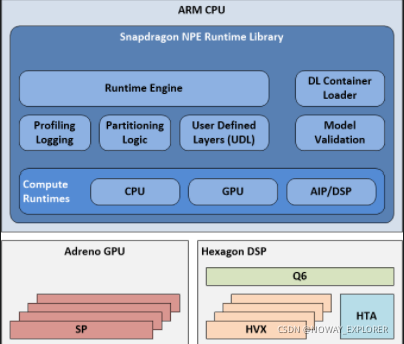

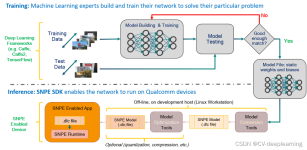

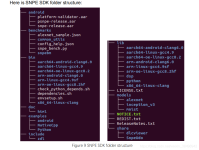

本文档提供了SnapdragonTM神经处理引擎(SNPE)软件开发工具包(SDK)用户指南和API参考指南。 Capabilities Snapdragon神经处理引擎(SNPE)是用于执行深度神经网络的Qualcomm Snapdragon软件加速运行时。 使用...

如果开发就是使用的C++,那比较容易实现用户定义层,但如果是运行在Android上,开发者需要将上层java代码通过JNI方式来调用NPE原生的C++编译好的.so文件,因为用户定义层的代码是不可能预先编译到NPE原生.so文件中的...

Docker image For SNPE Docker image for Snapdragon Neural Processing Engine SDK with caffe & adb Usage build docker build -t snpe . Run docker run -it --privileged -v ~/Git/snpe-1.13.0:/root/snpe -v...

SNPE 模型量化实战

标签: SNPE

高通snpe使用流程

snpe-benchmark

snpe报错 Invalid Slice inputs 4, only constant inputs supported

snpe分类量化训练例子

【代码】高通模型转换 Qnn /SNPE 安装。

snpe安装

标签: python tensorflow 开发语言

snpe安装

SNPE教程2-量化

标签: 边缘计算

snpe实现量化

This section describes the concepts behind the quantization algorithm used in SNPE. These concepts are used bysnpe-dlc-quantizeand is also used by SNPE for input quantization when using the DSP ...

DL Container Loader: SNPE使用后缀为dlc的模型文件,提供了模型load函数。 Model Validation: 检查输入模型与所选择的运行后端是否合法。 Runtime Engine: 选择运行模式的API,包括CPU,GPU,DSP和AIP四种运行模式...

推荐文章

- 【vue-treeselect+vxe-table】数据量大的时候懒加载,数据回显,输入框绑值,末级节点不要前面的箭头等问题详解_treeselect显示加载中-程序员宅基地

- 【从0入门JVM】-01Java代码怎么运行的_代码如何在jvm中运行-程序员宅基地

- TreeViewer应用实例(ITreeContentProvider与LabelProvider的使用)-程序员宅基地

- 如何将别人Google云端硬盘中的数据进行保存_谷歌网盘怎么保存别人的资源-程序员宅基地

- java中查看数据类型_java查看数据类型-程序员宅基地

- Scrapy-redis分布式+Scrapy-redis实战-程序员宅基地

- web播放H.264/H.265,海康,大华监控摄像头RTSP流方案_海康api hls怎么取265的流-程序员宅基地

- HTML详解连载(7)-程序员宅基地

- PHP使用多线程-程序员宅基地

- 由excel一键生成json的小工具(基于python,仅支持单层嵌套)_excel转json github-程序员宅基地