文章目录一、spark二、java中编写spark运行代码1)导入依赖和插件2)代码本地运行打包到集群中运行,结果输出在hdfs上 一、spark 也是基于mr的计算,和Hadoop的MapReduce阶段底层一样 spark是基于内存进行数据处理...

”Java编程与Spark“ 的搜索结果

import java.utilimport org.apache.spark.sql.types.{DataTypes, StructField}import org.apache.spark.sql.{Row, SQLContext}import org.apache.spark.{SparkConf, SparkContext}object TelephoneData13 {def main...

在spark上运行wordcount程序,可以进行单词计数

一、使用Java语言开发sparkstreaming完成WordCount package Test; import org.apache.spark.SparkConf; import org.apache.spark.streaming.Durations; import org.apache.spark.streaming.api.java....

本文主要介绍spark sql读写es、structured streaming写入es以及一些参数的配置ES官方提供了对spark的支持,可以直接通过spark读写es,具体可以参考ES Spark Support文档(文末有地址)。以下是pom依赖,具体版本可以...

现在,存在另一个与Java中的Spark作业服务器进行通信的选项,即Spark-Job-Server-Client,它是Spark Job Server的Java客户端,实现了已安排的Rest API。 Spark-Job-Server-Client是Apache许可v2下的...

spark在java使用比较少,多是scala的用法,我这里介绍一下我在项目中使用的代码配置 详细算法的使用请点击我主页列表查看 版本 jar 版本 说明 spark 3.0.1 scala 2.12 这个版本注意和spark版本对应,只是...

所有练习都作为独立程序在本地模式下运行。 要进行动手操作,请通过以下命令行检索代码: $ git clone https://github.com/nivdul/spark-in-practice.git 然后您可以在 IntelliJ 或 Eclipse 中导入项目。 如果您想...

apache-spark的类路径是动态构建的(以适应每个应用程序的用户代码),这使得它容易受到此类问题的影响。@用户7337271的回答是正确的,但是还有一些问题,这取决于您使用的集群管理器(“master”)。首先,Spark应用...

来我的Spark专栏:https://blog.csdn.net/aaron_ch/category_10777950.html 一起学习进步怎么用Java编写Spark并本地调试

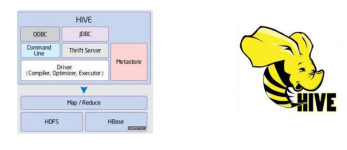

java spark hive

项目实战:Java一站式解决Hive内用Spark取数,新建ES索引,灌入数据,并且采用ES别名机制,实现ES数据更新的无缝更新,底层采用Spark计算框架,数据较快。

spark 编程可用的语言不止一种,这里讲一下如何用 Java 进行 spark 编程

本源码项目是基于Scala和Java的Spark Binlog数据源设计,包含56个文件,主要使用Scala、Java和Shell编程语言。该项目是一个支持HBase/MySQL Binlog的Spark structured streaming数据源。通过该项目,开发者可以学习...

《Spark 2.0技术预览:更容易、更快速、更智能》文章中简单地介绍了Dataset介绍Dataset是从Spark 1.6开始引入的一个新的抽象,当时还是处于alpha版本;然而在Spark 2.0,它已经变成了稳定版了。下面是DataSet的官方...

本帖最后由 hanyunsong 于 2020-7-16 17:21 编辑Apache Spark是用于大规模数据处理的统一分析引擎. 它提供Java,Scala,Python和R中的高级API,以及支持常规执行图的优化引擎. 它还支持一组丰富的更高级别的工具,...

JAVA实现Spark的任务提交

java-sparkstreaming-kinesis-window 这个项目是用 Maven 在 Java 中运行一个 Spark Streaming 应用程序,并将使用一个

原来程序是将所有jar打包到libs目录下,然后运行生成好的run.sh。现在要使用spark-submit将它提交到spark上运行。几经波折之后,终于圆满完成。 首先遇到的问题是如何使用gradle将工程打包成可执行的jar文件。这个...

最后,我们使用collectAsMap方法将结果收集到一个Map对象中,并输出结果。我们首先创建了一个SparkContext对象,然后...在本节中,我们将编写一个简单的Spark应用程序,该程序将读取一个文本文件并计算单词出现的次数。

1.背景介绍 1. 背景介绍 随着数据的增长和复杂性,传统的批处理技术已经无法满足现代...在本文中,我们将深入探讨Java的Spark与流式大数据处理,涵盖其核心概念、算法原理、最佳实践、应用场景和实际应用。 2. 核...

主要介绍了在IntelliJ IDEA中创建和运行java/scala/spark程序的教程,本文通过实例代码给大家介绍的非常详细,对大家的学习或工作具有一定的参考借鉴价值,需要的朋友可以参考下

扩展:Java编写Spark程序前言演示使用JavaAPI编写Spark程序完成WordCount 前言 Spark的源码是使用Scala编写的,那么开发时肯定是使用Scala进行开发最好,和官方的底层源码"兼容性更好" 但是有些公司觉得Scala的学习...

JPMML-SparkML Java库和命令行应用程序,用于将Apache Spark ML管道转换为PMML。目录特征支持的管道阶段类型: 特征提取器,变压器和选择器: feature.Bucketizer feature.ChiSqSelectorModel (拟合feature....

推荐文章

- 用好ASP.NET 2.0的URL映射-程序员宅基地

- C语言等级考试是把题目删了,历年全国计算机的等级考试二级C语言上机考试地训练题目库及答案详解(72页)-原创力文档...-程序员宅基地

- Microsoft Office显示正在更新无法打开的问题_正在更新microsoft 365和office-程序员宅基地

- 非常好的Ansible入门教程(超简单)-程序员宅基地

- 【Gradle-8】Gradle插件开发指南-程序员宅基地

- 使用PL/SQL Developer软件解锁_plsqldev表格锁怎么打开-程序员宅基地

- 【Windows Server 2019】Web服务 IIS 配置与管理——配置 IIS 进阶版 Ⅳ_iis默认路径-程序员宅基地

- 网络中的各层协议_发送消息时各层协议-程序员宅基地

- UCRT: VC 2015 Universal CRT, by Microsoft_vc15rt-程序员宅基地

- 关于EntityFramework 7 开发学习_entiry framework 7 书籍-程序员宅基地