【机器学习】Sklearn-cluster聚类方法_sklearn cluster-程序员宅基地

技术标签: 机器学习

Classes1

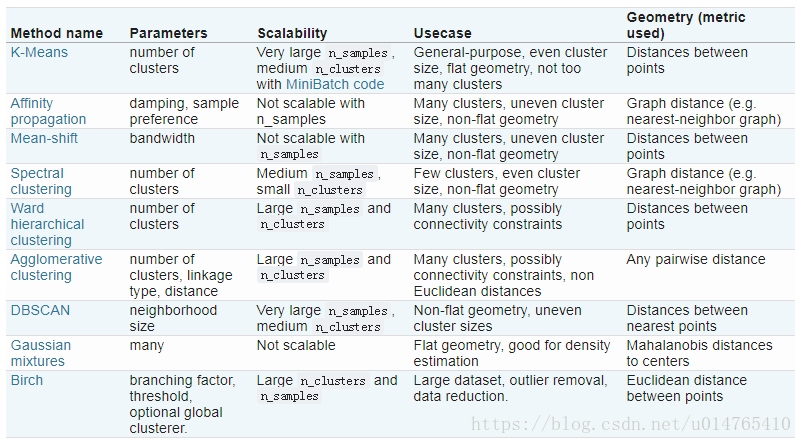

各种聚类方法特性汇总:

sklearn.cluster.KMeans

from sklearn.cluster import KMeans

KMeans(n_clusters=8,init='k-means++',n_init=10,max_iter=300,tol=0.0001,precompute_distances='auto',verbose=0,random_state=None,copy_x=True,n_jobs=1,algorithm='auto')

#n_clusters:class的个数;

#max_inter:每一个初始化值下,最大的iteration次数;

#n_init:尝试用n_init个初始化值进行拟合;

#tol:within-cluster sum of square to declare convergence;

#init=‘k-means++’:可使初始化的centroids相互远离;

算法要点:

1、将training data (X)分为k clusters;

2、object function:

3、缺陷:

1)KMeans假设clusters是convex or isotropics;他不能很好的拟合elongated clusters or manifolds with irregular shape;

2)欧几里得距离会随着特征数量的增加(dimension),而变得越来越膨胀;从而影响模型收敛。针对这一问题,一个好的解决方法是:可以利用PCA等降维工具先将data的特征数目降低在可接受的范围内,然后在计算其欧几里得距离;

3)initial centroids选择不慎,可能会使模型convergence to local minimum;利用KMeans的参数init=‘k-means++’,可以使initial centroids相互远离,从而使模型收敛到一个更好的结果。

sklearn.cluster.MiniBatchKMeans

from sklearn.cluster import MiniBatchKMeans(n_clusters=8,init='k-means++',max_iter=100,batch-size=100,verbose=0,compute_labels=True,random_state=None,tol=0.0,max_no_improvement=10,init_size=None,n_init=3,reassignment_ration=0.01)

#n_clusters: class数量;

#batch_size:用来拟合KMeans的subset size;

#compute_labels=True:将在batch_size上的拟合结果应用到整个data;

#tol:目标函数变化值<tol时,停止迭代;

#max_no_improvement:当max_no_improvement个batchset停止迭代时,给出最终的模型拟合结果;

算法要点:

相比标准的KMeans算法,MiniBatchKMeans是在subset进行模型拟合;其拟合效果比标准的KMeans算法略差(差别较小);但是MiniBatchKMeans的收敛速度要快于KMeans;

sklearn.cluster.AffinityPropagation

from sklearn.cluster import AffinityPropagation

AffinityPropagation(damping=0.5,max_iter=200,convergence_iter=15,copy=True,preference=None,affinity='euclidean',verbose=False)

#damping:减振因子,用来避免在iteration中r,a的来回震荡;

#preference???

#convergence_iter:在estimated cluster数量不变后,还要进行的iteration次数;

#affinity:用来估计样本之间亲密度的函数:{precomputed,euclidean},{事先定义,欧几里得}

算法要点:

1)工作原理:

AffinityPropagation不需要在运行算法前确定聚类的个数;AffinityPropagation的要旨是选择exampler(data中实际存在的点),用来代表data(exampler的初始化主要是通过preference设定的);

在算法中,exampler的选择主要是通过两个函数进行的:responsibility r(i,k):the responsiblity of sample k to be the exampler of sample i,availability a(i,k):the availability of sample k to be the exampler of sample i;

在算法开始时,将r(i,k)和a(i,k)均设为0,iteration,直到r,a都达到收敛;为了减小r,a在iteration中的震荡,可以引入减振因子(可用damping参数实现);

2)缺陷:算法时间复杂度和空间复杂度均很高;

3)相关公式:

4)参考博文

sklearn.cluster.MeanShift

from sklearn.cluster import MeanShift

MeanShift(bandwidth=None,seeds=None,bin_seeding=False,min_bin_freq=1,cluster_all=True,n_jobs=1)

算法要点:

1)缺陷:由于算法运行过程中需要多次计算最近邻points,因此,该算法的可扩展性不高;estimate_bandwidth function,相比MeanShift算法具有更低的可扩展性,因此,如果在MeanShift算法中引入estimate_bandwidth,将进一步限值MeanShift的使用;

2)参考博文:

MeanShift聚类算法

MeanShift算法介绍

sklearn.cluster.SpectralClustering

from sklearn.cluster import SpectralClustering(n_clusters=8,eigen_solver=None,random_state=None,n_init=10,gamma=1.0,affinity='rbf',n_neighbors=10,eigen_tol=0.0,assign_labels='kmeans',degree=3,coef0=1,kernel_params=None,n_jobs=1)

#n_clusters:聚类的个数;

#eigen_solver:使用的特征值分解策略;

#gamma:计算相似矩阵时,如果使用核函数,该核函数的系数;

#affinity:计算相似度时使用的距离公式;

#n_neighbors:利用k近邻方法构建邻接矩阵时,所使用的k近邻;

#eigen_tol:Stopping criterion for eigendecomposition of the Laplacian matrix when using arpack eigen_solver.

#assign_labels:通过求解“拉普拉斯矩阵特征值”,获得指示向量矩阵(类似于降维后的特征),在指示向量矩阵的基础上,对矩阵各行,运用assign_labels进行聚类;取值:{kmeans,discretize};

#degree:Degree of the polynomial kernel. Ignored by other kernels;

#coef0:Zero coefficient for polynomial and sigmoid kernels. Ignored by other kernels.

#kernel_params:Parameters (keyword arguments) and values for kernel passed as callable object. Ignored by other kernels.

#n_jobs:The number of parallel jobs to run. If -1, then the number of jobs is set to the number of CPU cores.算法要点:

1)优点:

谱聚类只需要数据之间的相似度矩阵,因此对于处理稀疏数据的聚类很有效。这点传统聚类算法比如K-Means很难做到;

由于使用了降维,因此在处理高维数据聚类时的复杂度比传统聚类算法好。

2)缺点:

如果最终聚类的维度非常高,则由于降维的幅度不够,谱聚类的运行速度和最后的聚类效果均不好。

聚类效果依赖于相似矩阵,不同的相似矩阵得到的最终聚类效果可能很不同。

3)参考博文:

谱聚类原理总结

谱聚类及其实现详解

sklearn.cluster.AgglomerativeClustering

from sklearn.cluster import AgglomerativeClustering

AgglomerativeClustering(n_clusters=2,affinity='euclidean',memory=None,connectivity=None,compute_full_tree='auto',linkage='ward',pooling_func=<function mean>)

#affinity:距离计算公式:{eucidean,l1,l2,cosine,manhattan,precomputed}

#memory:是否要缓冲;

#connectivity:是否设定connectivity matrix;

#compute_full_tree:是否要进行完全聚类;

#linkage:进行聚类的标准:{ward,complete,average}

算法要点:

1)将两个不同的类进行融合的标准有3:

ward:minimizes the sum of squared differences within all clusters;

complete:minimizes the maximum distance between observations of pairs of clusters;

average:minimizes the average of the distances between all observations of pairs of clusters.

note that:Agglomerative cluster 可能会导致各个cluster间大小的不均衡;complete 能够导致非常不均衡簇的产生,相比而言 ward 可以产生相对均衡的簇,但是,ward只能采用欧几里得距离公式,不能使用其他的距离公式,因此,如果要用其他的距离公式进行聚类,可使用 average 策略。

2)在算法中引入connectivity matrix 不仅可以将算法应用于更大的数据集,而且可以禁止聚类在特定的subset之间发生,如下图,可保证聚类不在各个folds间发生:

3)度量两点之间距离的公式:{l1,l2,manhattan,cosine,ecludiean}

l1 :比较实用于稀疏矩阵;

cosine :对于数据全局的缩放,可以保持距离不变;

sklearn.cluster.DBSCAN

from sklearn.cluster import DBSCAN

DBSCAN(eps=0.5,min_samples=5,metric='euclidean',mtric_params=None,algorithm='auto',leaf_size=30,p=None,n_jobs=1)

#eps:对象半径;

#min_samples:一个核心对象应该拥有的最少sample数;

#metric:计算样本之间距离的公式;{precomputed,callable}

#algorithm:用来找最近邻样本点算法{'auto','ball_tree','ke_tree'}

#leaf_size:kd_tree或ball_tree中的叶子节点数;决定了搜索快慢;

算法要点:

1)对于给定ordered data,其多次运用该算法的聚类结果相同,但是,对于不同order的同一data,可能会得到不同的结果;

2)如果一个data中重复value较多,可以做成稀疏矩阵,将各个数据根据其重复度设定一个weight,进而,在用DBSCAN拟合数据;

3)参考博文:DBSCAN简介

sklearn.cluster.Birch

from sklearn.cluster import Birch

Birch(threshold=0.5,branching_factor=50,n_clusters=3,compute_labels=True,copy=True)

#threshold:subcluster的半径,如果某一样本点的加入,使subcluster半径超过这个值,则该样本会被分到其它的subcluster;

#branching_factor:每个node拥有的CF个数,如果新加入的CF使node中的CF数超过设定值,则将该Node一分为二;

#n_clusters:想要得到的cluster数量;如果n_cluster=None,则输出叶子结点中所有CF;如果n_cluster= int,则将叶子节点中的CF再次进行聚类;如果n_cluster=instance of sklearn.cluster.model,则将叶子节点中的CF看作new data,利用该model进行聚类;

#copy=False:将overwritten data;

#compute_labels=True:计算所有data sample的label;

算法要点:

1)优点:

节约内存,所有的样本都在磁盘上,CF Tree仅仅存了CF节点和对应的指针。

聚类速度快,只需要一遍扫描训练集就可以建立CF Tree,CF Tree的增删改都很快。

可以识别噪音点,进行异常点检测,还可以对数据集进行初步分类的预处理,降低数据实例数量;

Birch和MiniBatch一样,都使用与数据量较大的情况,但是,MiniBatch适用于类别数较少或中等的情况,而Birch使用与类别数较大的情况;

2)缺点:

由于CF Tree对每个节点的CF个数有限制,导致聚类的结果可能和真实的类别分布不同.

对高维特征的数据聚类效果不好。当n_feature > 20时,此时可以选择Mini Batch K-Means。

如果数据集的分布簇不是类似于超球体,或者说不是凸的,则聚类效果不好。

3)参考博文:BIRCH聚类算法原理

clustering performance evaluation

from sklearn import metrics

metrics.adjusted_rand_score(labels_true,labels_pred)

metrics.adjuested_mutual_info_score(labels_true,labels_pred)

metrics.homogeneity_score(labels_true,labels_pred)

metrics.completeness_score(labels_true,labels_pred)

metrics.v_measure_score(labels_true,labels_pred)

metrics.homogeneity_completeness_v_measure(labels_true,labels_pred)

metrics.fowlkes_mallows_score(labels_true,labels_pred)

metrics.silhouette_score(X,labels,metric='euclidean')

metrics.calinski_harabaz_score(X,labels)

参考文献:Clustering

Class 2

sklearn.cluster.Biclustering

Biclustering 简介

Biclustering同时对rows和columns进行聚类,每一个cluster(rows,columns)被叫做一个bicluster,在聚类的过程中,会重新排列data matrix的rows和columns;比如,一个data matrix(10,10),通过Biclustering,可能会形成一个(3,2)的bicluster(submatrix);

sklearn.cluster.bicluster中有两种biclustering的function:

SpectralBiclustering

sklearn.cluster.bicluster.SpectralBiclustering(n_clusters=3,method='bistochastic',n_components=6,n_best=3,svd_method='randomized',n_svd_vecs=None,mini_batch=False,init='k-means++',n_init=10,n_jobs=1,random_state=None)

该algorithm形成的是一个hidden checkboard structure biclusters,每一个checkboard内各个点的值几乎相同,因此,该checkboard structure提供了一个对原data的近似;

checkboard structure如下图所示:

SpectralCoclustering

sklearn.cluster.bicluster.SpectralCoclustering(n_clusters=3,svd_method='randomized',n_svd_vecs=None,mini_batch=False,init='k-means++',n_init=10,n_jobs=1,random_state=None)

该algorithm形成的是一个diagonal structure,diagonal上的每一个bicluster代表了data matrix中的high values。此算法通过对data matrix gaph进行归一化,从而找到数据图中的heavy subgraph(The algorithm approximates the normalized cut of this graph to find heavy subgraphs.)其结构如下图所示:

---------------------

作者:Wbq_Zero

来源:CSDN

原文:https://blog.csdn.net/u014765410/article/details/82784885

版权声明:本文为博主原创文章,转载请附上博文链接!

智能推荐

获取大于等于一个整数的最小2次幂算法(HashMap#tableSizeFor)_整数 最小的2的几次方-程序员宅基地

文章浏览阅读2w次,点赞51次,收藏33次。一、需求给定一个整数,返回大于等于该整数的最小2次幂(2的乘方)。例: 输入 输出 -1 1 1 1 3 4 9 16 15 16二、分析当遇到这个需求的时候,我们可能会很容易想到一个"笨"办法:..._整数 最小的2的几次方

Linux 中 ss 命令的使用实例_ss@,,x,, 0-程序员宅基地

文章浏览阅读865次。选项,以防止命令将 IP 地址解析为主机名。如果只想在命令的输出中显示 unix套接字 连接,可以使用。不带任何选项,用来显示已建立连接的所有套接字的列表。如果只想在命令的输出中显示 tcp 连接,可以使用。如果只想在命令的输出中显示 udp 连接,可以使用。如果不想将ip地址解析为主机名称,可以使用。如果要取消命令输出中的标题行,可以使用。如果只想显示被侦听的套接字,可以使用。如果只想显示ipv4侦听的,可以使用。如果只想显示ipv6侦听的,可以使用。_ss@,,x,, 0

conda activate qiuqiu出现不存在activate_commandnotfounderror: 'activate-程序员宅基地

文章浏览阅读568次。CommandNotFoundError: 'activate'_commandnotfounderror: 'activate

Kafka 实战 - Windows10安装Kafka_win10安装部署kafka-程序员宅基地

文章浏览阅读426次,点赞10次,收藏19次。完成以上步骤后,您已在 Windows 10 上成功安装并验证了 Apache Kafka。在生产环境中,通常会将 Kafka 与外部 ZooKeeper 集群配合使用,并考虑配置安全、监控、持久化存储等高级特性。在生产者窗口中输入一些文本消息,然后按 Enter 发送。ZooKeeper 会在新窗口中运行。在另一个命令提示符窗口中,同样切换到 Kafka 的。Kafka 服务器将在新窗口中运行。在新的命令提示符窗口中,切换到 Kafka 的。,应显示已安装的 Java 版本信息。_win10安装部署kafka

【愚公系列】2023年12月 WEBGL专题-缓冲区对象_js 缓冲数据 new float32array-程序员宅基地

文章浏览阅读1.4w次。缓冲区对象(Buffer Object)是在OpenGL中用于存储和管理数据的一种机制。缓冲区对象可以存储各种类型的数据,例如顶点、纹理坐标、颜色等。在渲染过程中,缓冲区对象中存储的数据可以被复制到渲染管线的不同阶段中,例如顶点着色器、几何着色器和片段着色器等,以完成渲染操作。相比传统的CPU访问内存,缓冲区对象的数据存储和管理更加高效,能够提高OpenGL应用的性能表现。_js 缓冲数据 new float32array

四、数学建模之图与网络模型_图论与网络优化数学建模-程序员宅基地

文章浏览阅读912次。(1)图(Graph):图是数学和计算机科学中的一个抽象概念,它由一组节点(顶点)和连接这些节点的边组成。图可以是有向的(有方向的,边有箭头表示方向)或无向的(没有方向的,边没有箭头表示方向)。图用于表示各种关系,如社交网络、电路、地图、组织结构等。(2)网络(Network):网络是一个更广泛的概念,可以包括各种不同类型的连接元素,不仅仅是图中的节点和边。网络可以包括节点、边、连接线、路由器、服务器、通信协议等多种组成部分。网络的概念在各个领域都有应用,包括计算机网络、社交网络、电力网络、交通网络等。_图论与网络优化数学建模

随便推点

android 加载布局状态封装_adnroid加载数据转圈封装全屏转圈封装-程序员宅基地

文章浏览阅读1.5k次。我们经常会碰见 正在加载中,加载出错, “暂无商品”等一系列的相似的布局,因为我们有很多请求网络数据的页面,我们不可能每一个页面都写几个“正在加载中”等布局吧,这时候将这些状态的布局封装在一起就很有必要了。我们可以将这些封装为一个自定布局,然后每次操作该自定义类的方法就行了。 首先一般来说,从服务器拉去数据之前都是“正在加载”页面, 加载成功之后“正在加载”页面消失,展示数据;如果加载失败,就展示_adnroid加载数据转圈封装全屏转圈封装

阿里云服务器(Alibaba Cloud Linux 3)安装部署Mysql8-程序员宅基地

文章浏览阅读1.6k次,点赞23次,收藏29次。PS: 如果执行sudo grep 'temporary password' /var/log/mysqld.log 后没有报错,也没有任何结果显示,说明默认密码为空,可以直接进行下一步(后面设置密码时直接填写新密码就行)。3.(可选)当操作系统为Alibaba Cloud Linux 3时,执行如下命令,安装MySQL所需的库文件。下面示例中,将创建新的MySQL账号,用于远程访问MySQL。2.依次运行以下命令,创建远程登录MySQL的账号,并允许远程主机使用该账号访问MySQL。_alibaba cloud linux 3

excel离散度图表怎么算_excel离散数据表格-Excel 离散程度分析图表如何做-程序员宅基地

文章浏览阅读7.8k次。EXCEL中数据如何做离散性分析纠错。离散不是均值抄AVEDEV……=AVEDEV(A1:A100)算出来的是A1:A100的平均数。离散是指各项目间指标袭的离散均值(各数值的波动情况),数值较低表明项目间各指标波动幅百度小,数值高表明波动幅度较大。可以用excel中的离散公式为STDEV.P(即各指标平均离散)算出最终度离散度。excel表格函数求一组离散型数据,例如,几组C25的...用exc..._excel数据分析离散

学生时期学习资源同步-JavaSE理论知识-程序员宅基地

文章浏览阅读406次,点赞7次,收藏8次。i < 5){ //第3行。int count;System.out.println ("危险!System.out.println(”真”);System.out.println(”假”);System.out.print(“姓名:”);System.out.println("无匹配");System.out.println ("安全");

linux 性能测试磁盘状态监测:iostat监控学习,包含/proc/diskstats、/proc/stat简单了解-程序员宅基地

文章浏览阅读3.6k次。背景测试到性能、压力时,经常需要查看磁盘、网络、内存、cpu的性能值这里简单介绍下各个指标的含义一般磁盘比较关注的就是磁盘的iops,读写速度以及%util(看磁盘是否忙碌)CPU一般比较关注,idle 空闲,有时候也查看wait (如果wait特别大往往是io这边已经达到了瓶颈)iostatiostat uses the files below to create ..._/proc/diskstat

glReadPixels读取保存图片全黑_glreadpixels 全黑-程序员宅基地

文章浏览阅读2.4k次。问题:在Android上使用 glReadPixel 读取当前渲染数据,在若干机型(华为P9以及魅族某魅蓝手机)上读取数据失败,glGetError()没有抓到错误,但是获取到的数据有误,如果将获取到的数据保存成为图片,得到的图片为黑色。解决方法:glReadPixels实际上是从缓冲区中读取数据,如果使用了双缓冲区,则默认是从正在显示的缓冲(即前缓冲)中读取,而绘制工作是默认绘制到后缓..._glreadpixels 全黑