Transformer Meets Tracker: Exploiting Temporal Context for Robust Visual Tracking-程序员宅基地

Transformer Meets Tracker:Exploiting Temporal Context for Robust Visual Tracking

前言

CVPR 2021

此文只是概述,详细内容见文章。

论文

代码

一、Abstract

在视频对象跟踪中,连续帧之间存在丰富的时序上下文,在现有的跟踪器中已大大忽略了这些上下文。在这项工作中,我们连接单个视频帧,并通过一个用于稳定的对象跟踪的transformer架构探索它们的时序上下文。与在自然语言处理(NLP)任务中使用Transformer的经典用法不同,我们将其编码器和解码器分为两个并行分支,并在类似于孪生网络的跟踪框架中精心设计它们。Transformer编码器通过基于注意力的特征增强来促进目标模板,这有利于高质量跟踪模型的生成。Transformer解码器将跟踪提示从先前的模板传播到当前帧,从而简化了对象搜索过程。我们的Transformer辅助跟踪框架整洁并以端到端的方式进行了训练。使用提出的Transformer,一种简单的连体匹配方法就可以胜过当前表现最佳的跟踪器。通过将我们的Transformer与最新的判别式跟踪方法相结合,我们的方法在流行的跟踪基准上创下了一些新的最新记录。

二、Contribution

- 我们提出了一个整洁和新颖的Transformer辅助跟踪框架。 据我们所知,这是第一次尝试让Transformer参与视觉跟踪。

- 我们同时考虑其特征和注意力转换,以更好地探索Transformer的潜力。我们还修改了经典的Transformer,使其更好地适合跟踪任务。

- 为了验证推广,我们将我们设计的Transformer集成到两个流行的跟踪框架中。我们的跟踪器在7个基准上表现出令人鼓舞的结果。

三、Method

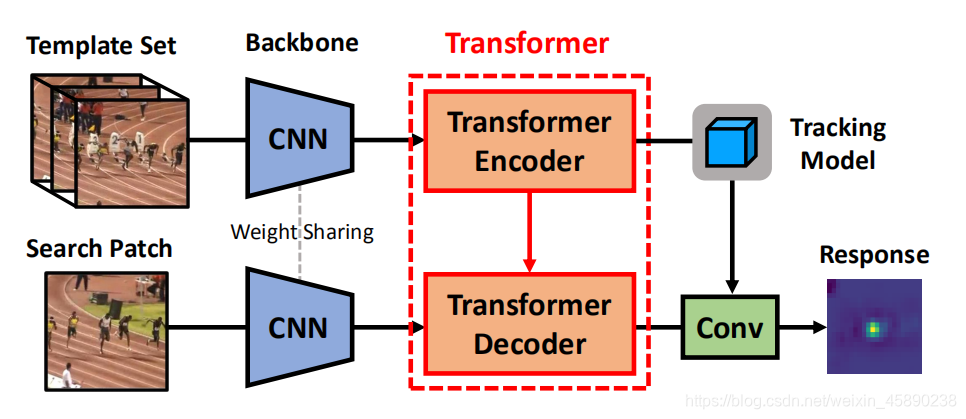

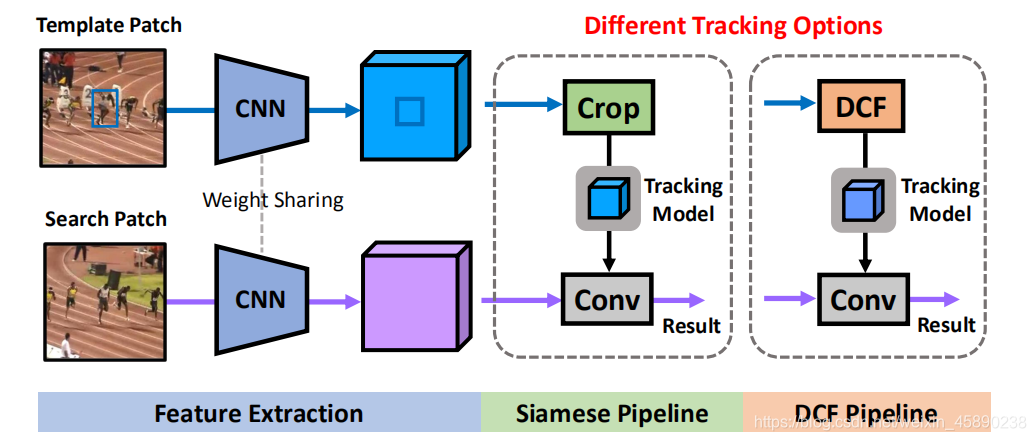

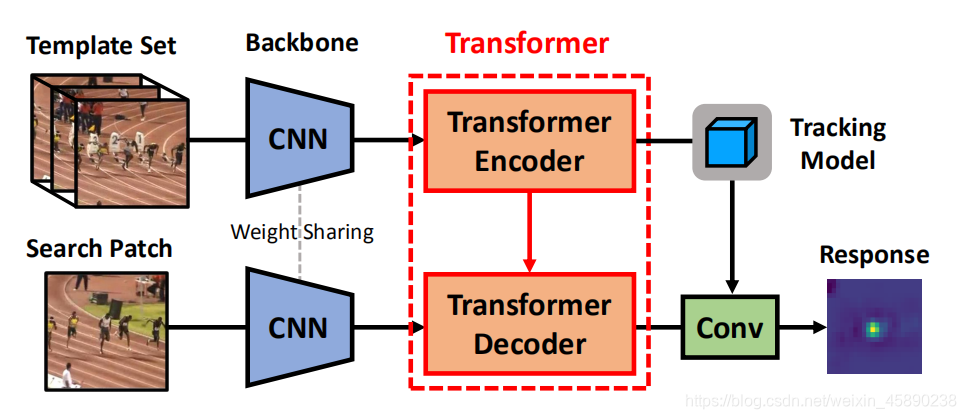

1、Revisting Tracking Frameworks

在详细说明我们用于对象跟踪的Transformer之前,为了完整性,我们简要回顾了最近流行的跟踪方法。如下图所示,孪生网络或判别相关滤波器(DCF)等主流跟踪方法可以表述为类似孪生的框架,其中顶部分支使用模板学习跟踪模型,底部分支专注于目标定位。

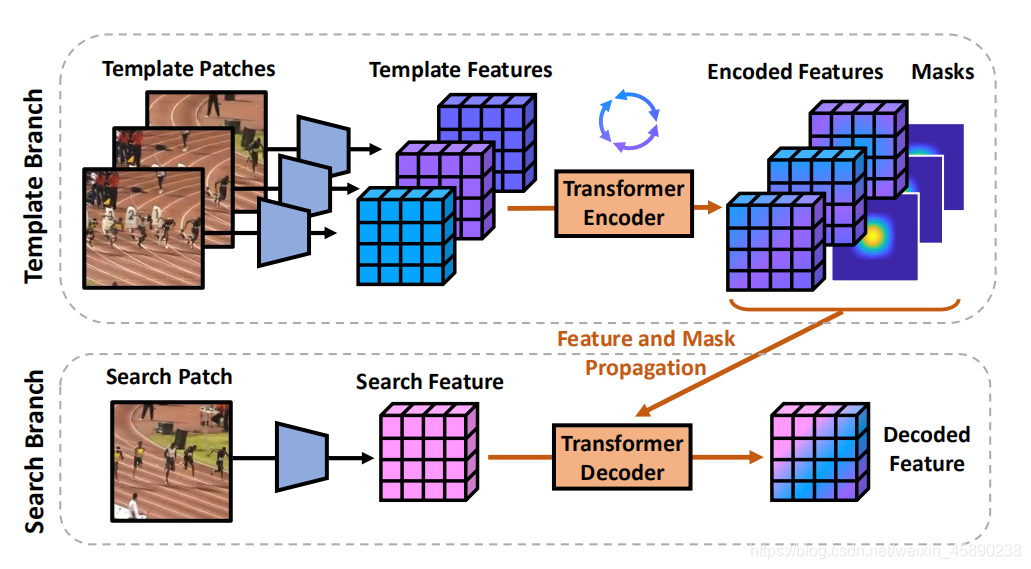

如下图。顶部:transformer编码器接收多个模板特征,以相互聚合表示。底部:transformer译码器将模板功能及其分配的掩码传播到search patch通道,以增强表示。

2、Transformer for Visual Tracking

主流的跟踪方法可以制定成一个类似孪生的框架。 我们的目标是通过框架关系建模和时序上下文传播来改进这样一个通用的跟踪框架,而不修改它们最初的跟踪方式,如模板匹配。

2.1 Transformer Overview

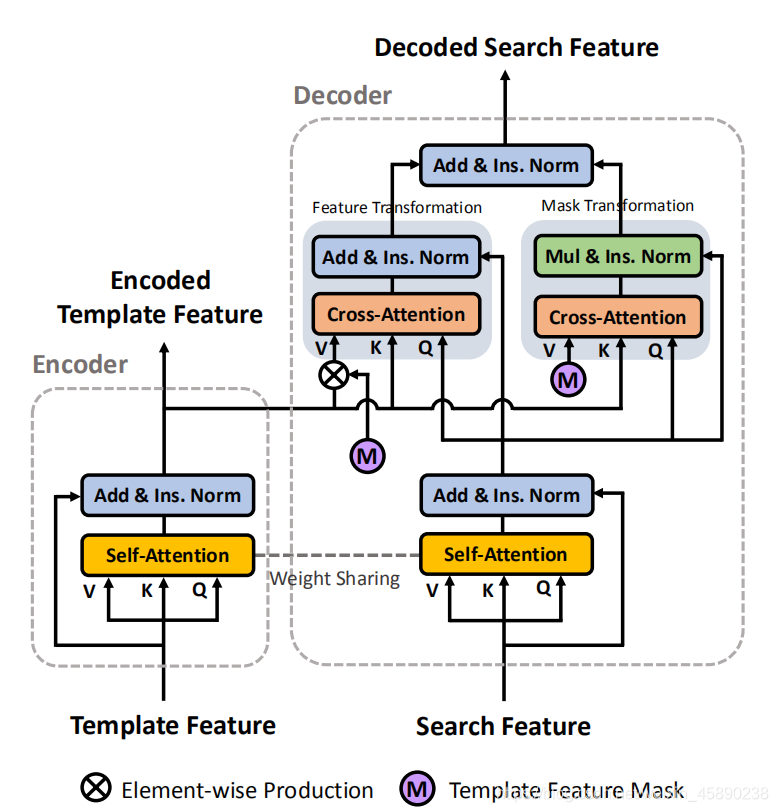

类似于经典的transformer结构,编码器利用self-attention块来相互加强多个模板特征。在解码过程中,cross-attention块连接模板,搜索分支传播时序上下文(例如:feature and attention)

为了适应视觉跟踪任务,在以下几个方面对经典Transformer进行了修改:

- 编码器-解码器分离。如下图所示,没有将NLP任务中的编码器和解码器进行级叠,而是将编码器和解码器分离为两个分支,以适应站点式的跟踪方法。

- 块权重共享。编码器和解码器中的self-attention块(图2中的黄色框)共享权重,这些权重在相同的特征空间中转换模板和搜索嵌入,以方便进一步的cross-attention计算。

- 实例规范化。在NLP任务中,word embeddings使用layer normalization进行单独归一化。 由于我们的transformer接收image feature embeddings,我们共同对这些嵌入在实例(image patch)上进行规范化,以保留有价值的image amplitude信息。

- 瘦身设计。效率对于视觉跟踪场景至关重要。为了达到良好的速度和性能平衡,我们通过省略全连接的前馈层和保持轻量级的single-head attention来简化经典transformer。

2.2 Transformer Encoder

- 经典transformer中的基本块是attention mechanism,输入为query: Q,key:K和value:V。

- 采用点积计算query和key之间的相似矩阵AK-Q(具体内容见文章)。

- 通过矩阵AK-Q,转换value。

- transformer编码器接收一组模板特征Ti,进一步连接以形成模板特征集成T

- 为了便于注意计算,我们reshape T to T’。

- transformer编码器的主要操作是self-attention,它的目的是相互加强来自多个模板的特征。为此,我们首先计算self-attention map: AT-T。

- 通过AT-T变换template feature得到残余项AT-TT’。并与T’相加,再进行Ins. Norm得到 T*

2.3 Transformer Decoder

- transformer解码器的输入为search patch feature:S。

- reshape S to S’,点积计算得到AS-S。

- S*=Ins. Norm(AS-SS’+S’)

2.3.1 Mask Transformation

- 得到 cross-attention matrix:AT-S

- 在视觉跟踪中,知道模板中的目标位置。通过m(y)构造了模板特征的高斯型掩码。

- 和T一样,连接mi得到M。resahpe为M’。

- S*mask=Ins. Norm(AT-SM’⊗S*)

2.3.2 Feature Transformation

- 除了spatial attention,传递context information从T到S也是可行的。

- 当背景场景在视频中发生剧烈变化时,传递目标表示是有益的,这对暂时传播是不合理的。因此,在特征转换之前,我们首先通过T*⊗M’对模板特征进行掩码,以抑制背景区域。

- 然后得到S * feat=Ins. Norm( AT-S(T*⊗M’) + S * )

最终得到S * final=Ins. Norm( S * feat +S * mask)

2.4 Tracking with Transformer-enhanced Features

transformer结构通过生成高质量的模板特征编码Tencoded和搜索特征解码Sdecoded来促进跟踪过程。 我们按照两种流行的范例使用Tencoded来学习跟踪模型:

- Siamese Pipeline:我们简单地将Tencoded中的目标特征裁剪为模板CNN内核,与Sdecoded进行卷积以产生响应,这与SiamFC中的互相关相同。

- DCF Pipeline:根据DiMP方法中的端到端DCF优化,我们生成一个鉴别CNN内核,使用Tencoded与Sdecoded的卷积生成响应。

在在线跟踪过程中,为了更好地利用时序线索,适应目标外观变化,我们动态更新模板集成T。具体来说,我们删除T中最古老的模板,每5帧将当前收集到的模板特征添加到T中。该功能集成维护的最大大小为20个模板。一旦模板集成T得到更新,我们将计算通过transformer编码器编码的新编码特征Tencoded。虽然transformer编码器使用稀疏(即每5帧),但transformer解码器在每帧中被利用,它通过将表示和注意线索从以前的模板传播到当前搜索补丁来生成每帧解码Sdecoded。

人们普遍认为,DiMP中的DCF公式优于孪生网络跟踪器中的简单互相关。然而,在实验中表明,在本文的transformer体系结构的帮助下,一个经典的孪生框架能够对抗最近的DIMP。同时,通过本文的transformer,DiMP跟踪器获得了进一步的性能改进。

四、Experiments

1. Implementation Details

基于孪生网络匹配和基于DiMP的跟踪框架,在下面的实验中,我们将transformer辅助跟踪器分别表示为TrSiam和TrDiMP。

- backbone为Res-Net 50

- 在编码器和解码器之前,我们还添加了一个卷积层(3×3Conv)将骨干特征通道从1024减少到512。

- 输入模板和搜索补丁是目标大小的6倍,并进一步调整到352×352。

- 使用LaSOT,TrackingNet,GOT-10K,COCO进行离线训练。

- 所提出的transformer网络以端到端的方式与原始跟踪部件(例如跟踪优化模型和IoUnet)联合训练。

- 我们的框架被训练为50个epoch,每个epoch1500次迭代,每批36个图像对。 采用ADAM优化器,初始学习速率为0.01,每15个epoch衰减因子为0.2。

- 在在线跟踪阶段,TrSiam和TrDiMP的主要区别在于跟踪模型的生成方式。 在预测目标定位的响应图后,都采用了最近的概率IoUnet[9]进行目标尺度估计。 我们的跟踪器是使用Py Torch在Python中实现的。 在单个Nvidia GTX1080Ti GPU上,TrSiam和TrdiMP分别工作约35帧/秒(FPS)和26帧/秒(FPS)。

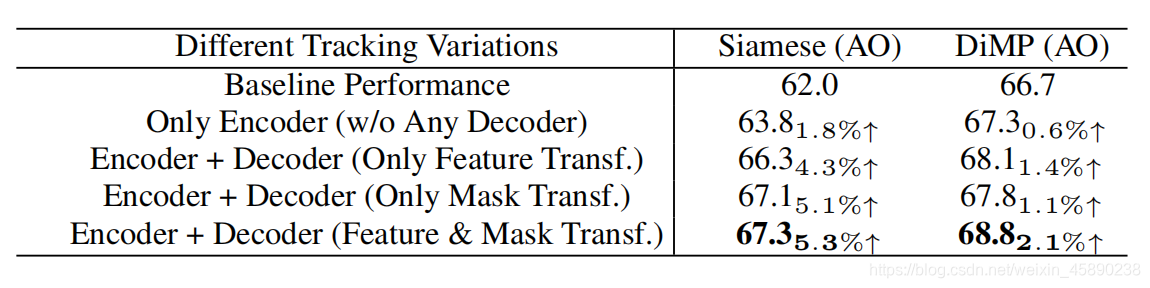

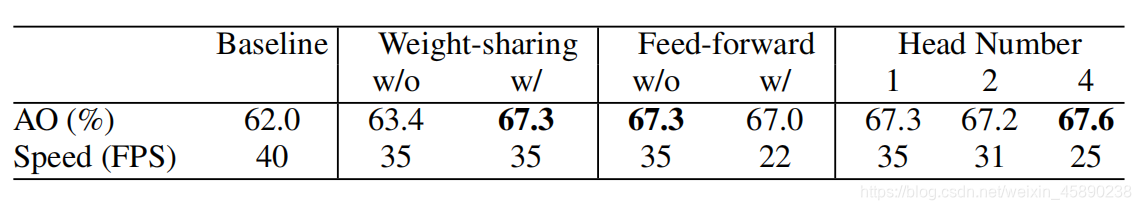

2. Ablation Study

为了验证本文设计的transformer结构的有效性,选择了180个视频的GOT-10k测试集来验证我们的TrSiam和TrDiMP方法。

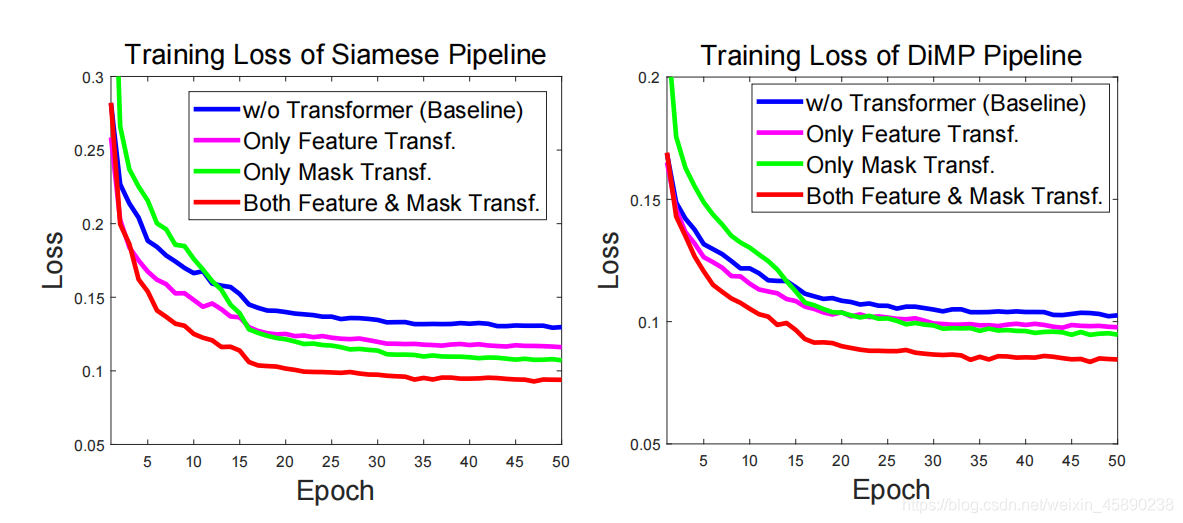

基于Siam和DIMP基线,验证了transformer中的每个组件:

- 对Siam和DiMP方法的transformer的实验。根据GOT-10k测试集的平均重叠(AO)来评估性能

- 对本文transformer体系结构的研究。基线跟踪器是TrSiam。评估指标是GOT-10k测试集上的平均重叠(AO)分数

- Siam(左)和DCF(右)的训练损失曲线图。 通过将特征转换和掩码转换结合起来,我们的方法大大减少了训练损失

3. State-of-the-art Comparisons

将提出的TrSiam和TrdiMP跟踪器与最近最先进的跟踪器进行了比较,测试集包括TrackingNet, GOT-10k,LaSOT, VOT2018, Need for Speed, UAV123,和OTB-2015。

-

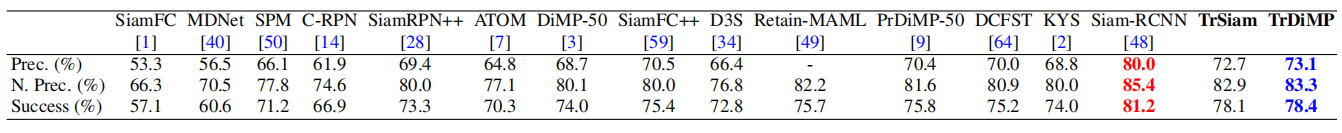

TrackingNet

-

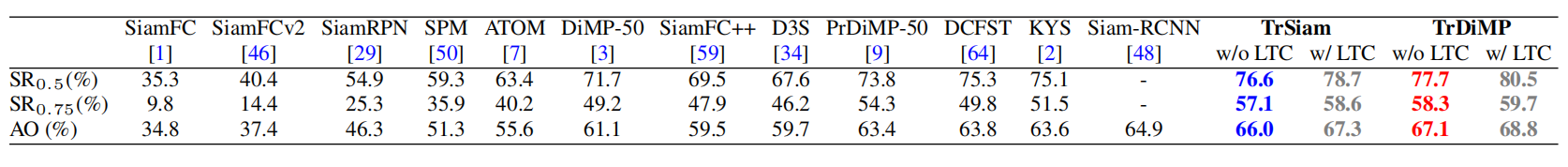

GOT-10k

-

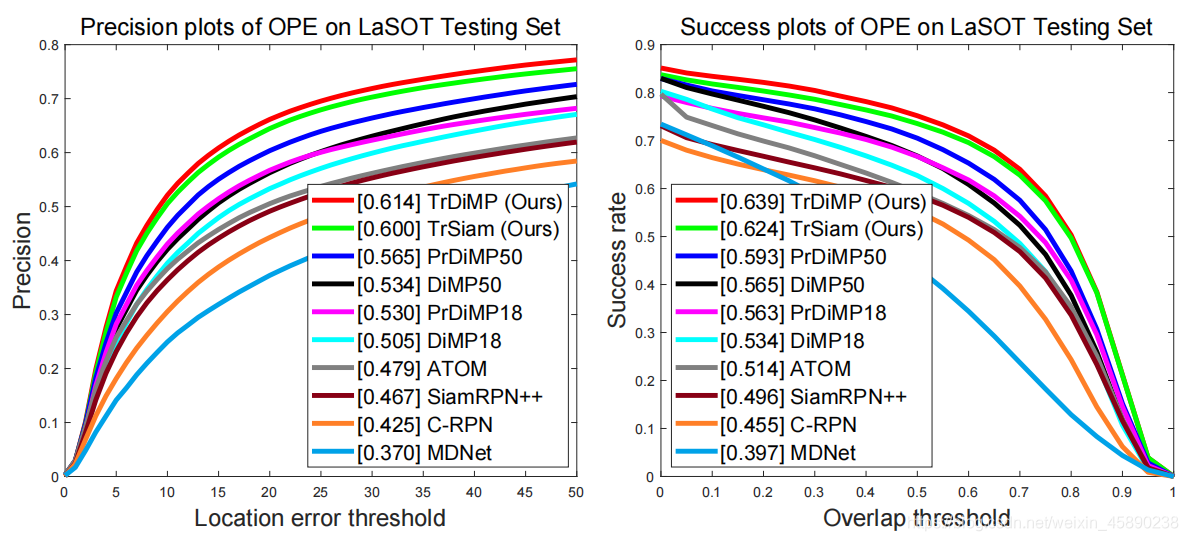

LaSOT

-

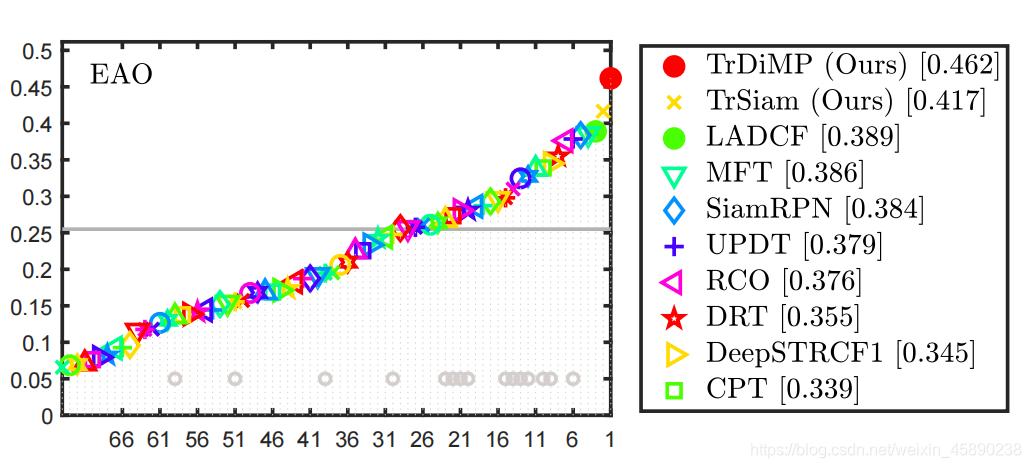

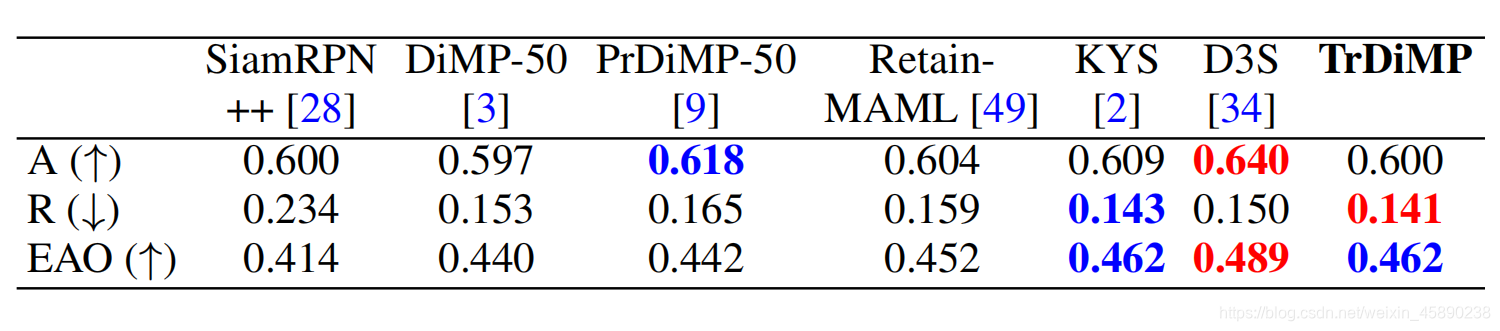

VOT2018

-

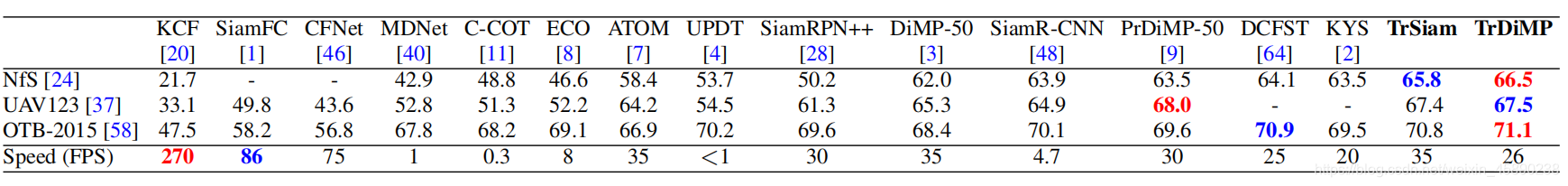

NfS,UAV23,OTB2015 datasets in terms of AUC score

详细分析见文章

ps:本人学疏才浅,若有不对的地方,请及时与我联系,进行更改。

智能推荐

远程桌面服务器连接失败,Windows服务器远程桌面连接失败是什么原因-程序员宅基地

文章浏览阅读6.1k次。1、先通过显示器直接连接的方式连接到那台连接出错的服务器上。登陆以后,在桌面上的此电脑图标上面点右键,选择属性。2、然后在属性页面中我们可以看到对应的系统版本是Windows Server 2016。CPU是intel xeon型号,内存是16g。这个时候我们点击它左上角的远程设置。3、在远程设置界面,我们可以看到,它默认的设置是允许远程到这台服务器上,但是它下面勾选了”仅允许运行使用网络级别身份..._远程桌面服务无法加入服务器 win-th0hfpjn9vr 上的连接代理。 错误: 当前异步消息

ApacheCN 翻译活动进度公告 2019.6.15-程序员宅基地

文章浏览阅读109次。Special Sponsors我们组织了一个开源互助平台,方便开源组织和大 V 互相认识,互相帮助,整合资源。请回复这个帖子并注明组织/个人信息来申请加入。请回复这个帖子来推荐希望翻译的内容。如果大家遇到了做得不错的教程或翻译项目,也可以推荐给我们。我们会联系项目的维护者,一起把...

Python培训课程深圳,群年轻人正在追捧Python-程序员宅基地

文章浏览阅读182次。记者 | 伍洋宇 袁伟腾编辑 | 文姝琪1李楠打算年底换份新工作,Python方向的、纯软件岗位,发挥空间更大的全栈开发工程师就很不错,目标月薪一万二。这使得他在今年下半年开始系统学习Python。因为本科是计算机专业,期间也自学过Python这门语言,李楠选择了继续自学。学Python真的有用吗?“当然有用啦,没用谁去学它啊。”今年24岁、刚刚毕业一年的李楠这么说。目前他在一家智能硬件公司做嵌入式开发软件工程师,月薪一万,工作是“往硬件里面写软件”,他觉得太枯燥了。“代码都是写好的,基..

Ubuntu下安装R,升级R版本,安装Rstudio,安装Rstudio Server以及安装Shiny Server_marutter-ubuntu-rrutter-focal.list-程序员宅基地

文章浏览阅读2.9k次。一、安装R只需要一步命令:sudo apt-get install r-base二、升级R版本第一步给Ubuntu指定PPA:sudo add-apt-repository ppa:marutter/rrutter第二步:sudo apt-get update第三步:sudo apt-get upgrade三、安装Rstudio直接去Rstudio官网下载最新版的Rst..._marutter-ubuntu-rrutter-focal.list

Redis5.0集群搭建(Redis Cluster)_rediscluster搭建 5.0-程序员宅基地

文章浏览阅读9.1k次。Redis5.0集群搭建RedisCluster_rediscluster搭建 5.0

题目-java基础_面向过程的程序设计是把计算机程序视为一系列的命令集合-程序员宅基地

文章浏览阅读405次。多线程和单线程线程不是越多越好,假如你的业务逻辑全部是计算型的(CPU密集型),不涉及到IO,并且只有一个核心。那肯定一个线程最好,多一个线程就多一点线程切换的计算,CPU不能完完全全的把计算能力放在业务计算上面,线程越多就会造成CPU利用率(用在业务计算的时间/总的时间)下降。但是在WEB场景下,业务并不是CPU密集型任务,而是IO密集型的任务,一个线程是不合适,如果一个线程在等待数据时,把CPU的计算能力交给其他线程,这样也能充分的利用CPU资源。但是线程数量也要有个限度,一般线程数有一个公式:最佳启_面向过程的程序设计是把计算机程序视为一系列的命令集合

随便推点

储能8串电池用140W DCDC电路2 USB_A 2个 TYPE-C 2A2C_pl56002-程序员宅基地

文章浏览阅读78次。储能8串电池,输出是2个C口,2个USBA口,功率是C1:140W,C2:100W,A1:18W,A2:18W.A1,A2不降功率,使用IP2736,IP2723T,IP2163,_pl56002

python3.8.1手机版下载-Python官方下载|Python最新版 V3.8.1 -推背图下载站-程序员宅基地

文章浏览阅读2k次。Python最新版是一款功能强大脚本编程软件。Python最新版它可以帮助编程人员更加便捷的进行代码编写,适合完成各种高层任务,兼容所有的操作系统中使用,因为它的便捷性,在程序员中得到广泛的应用,新入门的编程学习者可以使用它快速学习,欢迎前来下载!功能特点1、简单易学Python极其容易上手,因为Python有极其简单的说明文档 。2、免费开源Python是FLOSS(自由/开放源码软件)之一。3..._手机版python官网下载

Unity3D学习之(坦克大战解析)-程序员宅基地

文章浏览阅读3.9k次。欢迎大家光临我的博客!对坦克大战项目的解析:一、游戏模块主要是:注册模块、登录模块、我方模块、和敌方模块。①注册模块:可以跳转到登录界面!②登录模块:可以跳转到游戏界面!③我方模块:可以前后左右移动,可以发射子弹,可以死亡销毁。④敌方模块:可以可以发射子弹,追踪我方的位置,也可以随机出现,可以死亡销毁。 二、所用到的技术①键盘事件 //敌我双方通过键盘上下左右键的移动②位移 ...

【linux】进程和线程的几种状态及状态切换_linux线程状态-程序员宅基地

文章浏览阅读3.6k次,点赞46次,收藏54次。进程和线程的状态_linux线程状态

Java/Mysql数据库+SSM+学生信息管理系统 11578(免费领源码)计算机毕业设计项目推荐上万套实战教程JAVA、PHP,node.js,C++、python、大屏可视化等-程序员宅基地

文章浏览阅读1.1k次,点赞22次,收藏20次。免费领取项目源码,请关注●点赞●收藏并私信博主,谢谢~本系统以实际运用为开发背景,通过系统管理员可以对所有的学生和教师等人员以及学生相关联的一些学生管理、分配任务、完成任务、打卡签到、师生交流等数据信息进行统一的管理,方便资料的保留。教师和学生可以通过注册,然后登录到系统当中,对分配任务、完成任务、打卡签到以及师生交流这些信息进行查询管理。总的来说,系统的前台是通过Java页面展示,后台使用SSM这个框架,数据库采用目前流行的开源关系型数据库MYSQL。

如何在群辉NAS系统下安装cpolar套件,并使用cpolar内网穿透?_在群晖nas安装cpolar套件-程序员宅基地

文章浏览阅读1.2k次,点赞39次,收藏34次。群晖作为大容量存储系统,既可以作为个人的私有存储设备,也可以放在小型企业中作为数据中心使用。其强大的数据存储和管理功能,让其还能够胜任更多任务。但由于群晖的应用场景所限,这些功能通常只能在局域网内实现,想要让群晖NAS存储的数据能在公网访问到,我们可以借助cpolar的辅助,轻松实现在公共互联网访问内网群晖NAS上的数据。在这之前,我们还是需要了解下cpolar的基本操作方式。_在群晖nas安装cpolar套件