ICLR 2021 | 近期必读强化学习精选论文_强化学习论文推荐-程序员宅基地

技术标签: AMiner论文推荐 AMiner会议 AMiner会议论文推荐

强化学习(Reinforcement learning)是机器学习中的一个领域,强调如何基于环境而行动,以取得最大化的预期利益。其灵感来源于心理学中的行为主义理论,即有机体如何在环境给予的奖励或惩罚的刺激下,逐步形成对刺激的预期,产生能获得最大利益的习惯性行为。

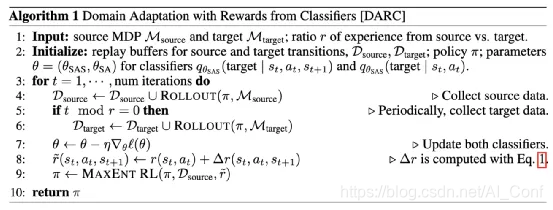

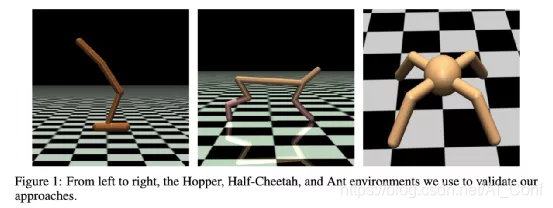

1.论文名称:Off-Dynamics Reinforcement Learning: Training for Transfer with Domain Classifiers

论文链接:https://www.aminer.cn/pub/5ef476b991e01165a63bbd0d?conf=iclr2021

简介:我们提出了一种简单,实用和直观的方法来进行强化学习中的领域适应。我们的方法源于这样的想法,即代理在源域中的经验应类似于其在目标域中的经验。基于RL的概率视图,我们正式表明,可以通过修改奖励函数来补偿动态差异来实现此目标。通过学习将源域转换与目标域转换区分开的辅助分类器,可以轻松估算此修改后的奖励函数。凭直觉,修改后的奖励功能对探员访问源和在源域中采取在目标域中不可能执行的动作的行为进行了惩罚。换句话说,对代理进行惩罚以进行过渡,该过渡将指示代理正在与源域而不是目标域进行交互。我们的方法适用于具有连续状态和动作的领域,不需要学习动态的显式模型。在离散和连续控制任务上,我们说明了这种方法的原理,并展示了其对高维任务的可扩展性

2.论文名称:Robust Reinforcement Learning using Adversarial Populations

论文链接:https://www.aminer.cn/pub/5f2be2ae91e011b36ba9cfaf?conf=iclr2021

简介:强化学习(RL)是用于控制器设计的有效工具,但可能会遇到鲁棒性问题,当底层系统动态受到干扰时,灾难性地失败。健壮的RL公式通过向动力学中添加最坏情况的对抗性噪声并将噪声分布构造为零和最小极大游戏的解决方案来解决此问题。但是,现有的针对鲁棒RL公式的学习解决方案的工作主要集中在针对单个对手训练单个RL代理。在这项工作中,我们证明了使用单个对手并不能始终如一地在对手的标准参数设置下产生对动态变化的鲁棒性。由此产生的政策很容易被新的对手利用。我们建议对Robust RL公式进行基于人群的扩充,在该公式中,我们在训练过程中随机初始化对手的人群并从该人群中均匀采样。我们在各种机器人技术基准上进行实证验证,即对抗性人群的使用会导致制定更强大的政策,从而改善分布外的概括性。最后,我们证明了这种方法在这些基准测试中提供了可比的鲁棒性和泛化性,如域随机化,同时避免了普遍存在的域随机化失败模式。

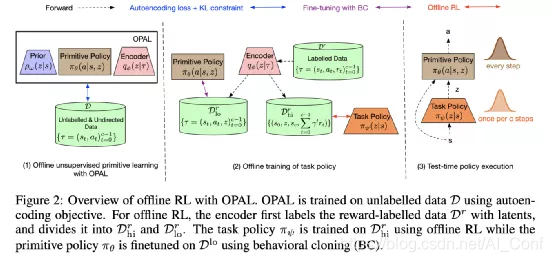

3.论文名称:OPAL: Offline Primitive Discovery for Accelerating Offline Reinforcement Learning

论文链接:https://www.aminer.cn/pub/5f980a2191e0112e0cda7ecb?conf=iclr2021

简介:强化学习(RL)在各种在线设置中均取得了骄人的成绩,在这种设置中,座席查询环境以获取过渡和奖励的能力实际上不受限制。但是,在许多实际应用中,情况恰恰相反:代理可能有权访问大量无方向的脱机体验数据,而对联机环境的访问受到严重限制。在这项工作中,我们专注于此离线设置。我们的主要见解是,当使用由各种行为组成的离线数据呈现时,一种有效利用此数据的方法是,在将这些原语用于下游任务学习之前,提取连续的和临时扩展的原语行为空间。以这种方式提取的基元有两个目的:它们描述了数据支持的行为与不支持的行为,从而有助于避免离线RL中的分布偏移。并且它们提供了一定程度的时间抽象,从而降低了有效视野,从而在理论上产生了更好的学习效果,并在实践中改善了离线RL。除了有益于脱机策略优化外,我们还表明,以这种方式执行脱机原始学习还可以用于改进几次模仿学习以及在各种基准域上进行在线RL的探索和转移。。

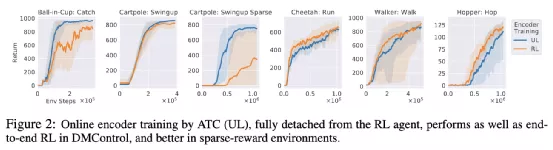

4.论文名称:Decoupling Representation Learning from Reinforcement Learning

论文链接:https://www.aminer.cn/pub/5f6488cf91e011f934ad258c?conf=iclr2021

简介:为了克服基于奖励的特征学习在图像深度增强学习(RL)中的局限性,我们提出将表示学习与策略学习分离。为此,我们引入了一种新的无监督学习(UL)任务,称为增强时空对比度(ATC),该任务训练卷积编码器以在图像增强和使用对比损失的情况下关联由短时间差分隔开的观察对。在在线RL实验中,我们表明在大多数环境中,仅使用ATC匹配或优于端到端RL训练编码器即可。此外,我们通过在专家演示中对编码器进行预训练并在RL代理中冻结权重后使用编码器,对几种领先的UL算法进行基准测试;我们发现,使用经过ATC训练的编码器的代理要优于其他代理。我们还针对来自多个环境的数据训练多任务编码器,并展示了对不同下游RL任务的概括。最后,我们消除了ATC的组件,并引入了新的数据增强功能,以在RL需要增强时从预训练的编码器中重放(压缩的)潜像。

5.论文名称:Maximum Reward Formulation In Reinforcement Learning

论文链接:https://www.aminer.cn/pub/5f802d3691e01119a5df72fc?conf=iclr2021

简介:强化学习(RL)算法通常用于最大化预期的累积回报(折扣或未折扣,有限或无限范围)。但是,现实世界中的一些关键应用(例如药物发现)不适合该框架,因为RL代理仅需要识别在轨迹内获得最高奖励的状态(分子),而无需针对预期进行优化 累积收益。在这项工作中,我们制定了一个目标函数,使沿着轨迹的预期最大报酬最大化,得出了Bellman方程的新颖函数形式,引入了相应的Bellman算子,并提供了收敛的证明。使用这种配方,我们在模拟现实世界中的药物发现流程的分子生成任务上获得了最先进的结果。

智能推荐

Docker 快速上手学习入门教程_docker菜鸟教程-程序员宅基地

文章浏览阅读2.5w次,点赞6次,收藏50次。官方解释是,docker 容器是机器上的沙盒进程,它与主机上的所有其他进程隔离。所以容器只是操作系统中被隔离开来的一个进程,所谓的容器化,其实也只是对操作系统进行欺骗的一种语法糖。_docker菜鸟教程

电脑技巧:Windows系统原版纯净软件必备的两个网站_msdn我告诉你-程序员宅基地

文章浏览阅读5.7k次,点赞3次,收藏14次。该如何避免的,今天小编给大家推荐两个下载Windows系统官方软件的资源网站,可以杜绝软件捆绑等行为。该站提供了丰富的Windows官方技术资源,比较重要的有MSDN技术资源文档库、官方工具和资源、应用程序、开发人员工具(Visual Studio 、SQLServer等等)、系统镜像、设计人员工具等。总的来说,这两个都是非常优秀的Windows系统镜像资源站,提供了丰富的Windows系统镜像资源,并且保证了资源的纯净和安全性,有需要的朋友可以去了解一下。这个非常实用的资源网站的创建者是国内的一个网友。_msdn我告诉你

vue2封装对话框el-dialog组件_<el-dialog 封装成组件 vue2-程序员宅基地

文章浏览阅读1.2k次。vue2封装对话框el-dialog组件_

MFC 文本框换行_c++ mfc同一框内输入二行怎么换行-程序员宅基地

文章浏览阅读4.7k次,点赞5次,收藏6次。MFC 文本框换行 标签: it mfc 文本框1.将Multiline属性设置为True2.换行是使用"\r\n" (宽字符串为L"\r\n")3.如果需要编辑并且按Enter键换行,还要将 Want Return 设置为 True4.如果需要垂直滚动条的话将Vertical Scroll属性设置为True,需要水平滚动条的话将Horizontal Scroll属性设_c++ mfc同一框内输入二行怎么换行

redis-desktop-manager无法连接redis-server的解决方法_redis-server doesn't support auth command or ismis-程序员宅基地

文章浏览阅读832次。检查Linux是否是否开启所需端口,默认为6379,若未打开,将其开启:以root用户执行iptables -I INPUT -p tcp --dport 6379 -j ACCEPT如果还是未能解决,修改redis.conf,修改主机地址:bind 192.168.85.**;然后使用该配置文件,重新启动Redis服务./redis-server redis.conf..._redis-server doesn't support auth command or ismisconfigured. try

实验四 数据选择器及其应用-程序员宅基地

文章浏览阅读4.9k次。济大数电实验报告_数据选择器及其应用

随便推点

灰色预测模型matlab_MATLAB实战|基于灰色预测河南省社会消费品零售总额预测-程序员宅基地

文章浏览阅读236次。1研究内容消费在生产中占据十分重要的地位,是生产的最终目的和动力,是保持省内经济稳定快速发展的核心要素。预测河南省社会消费品零售总额,是进行宏观经济调控和消费体制改变创新的基础,是河南省内人民对美好的全面和谐社会的追求的要求,保持河南省经济稳定和可持续发展具有重要意义。本文建立灰色预测模型,利用MATLAB软件,预测出2019年~2023年河南省社会消费品零售总额预测值分别为21881...._灰色预测模型用什么软件

log4qt-程序员宅基地

文章浏览阅读1.2k次。12.4-在Qt中使用Log4Qt输出Log文件,看这一篇就足够了一、为啥要使用第三方Log库,而不用平台自带的Log库二、Log4j系列库的功能介绍与基本概念三、Log4Qt库的基本介绍四、将Log4qt组装成为一个单独模块五、使用配置文件的方式配置Log4Qt六、使用代码的方式配置Log4Qt七、在Qt工程中引入Log4Qt库模块的方法八、获取示例中的源代码一、为啥要使用第三方Log库,而不用平台自带的Log库首先要说明的是,在平时开发和调试中开发平台自带的“打印输出”已经足够了。但_log4qt

100种思维模型之全局观思维模型-67_计算机中对于全局观的-程序员宅基地

文章浏览阅读786次。全局观思维模型,一个教我们由点到线,由线到面,再由面到体,不断的放大格局去思考问题的思维模型。_计算机中对于全局观的

线程间控制之CountDownLatch和CyclicBarrier使用介绍_countdownluach于cyclicbarrier的用法-程序员宅基地

文章浏览阅读330次。一、CountDownLatch介绍CountDownLatch采用减法计算;是一个同步辅助工具类和CyclicBarrier类功能类似,允许一个或多个线程等待,直到在其他线程中执行的一组操作完成。二、CountDownLatch俩种应用场景: 场景一:所有线程在等待开始信号(startSignal.await()),主流程发出开始信号通知,既执行startSignal.countDown()方法后;所有线程才开始执行;每个线程执行完发出做完信号,既执行do..._countdownluach于cyclicbarrier的用法

自动化监控系统Prometheus&Grafana_-自动化监控系统prometheus&grafana实战-程序员宅基地

文章浏览阅读508次。Prometheus 算是一个全能型选手,原生支持容器监控,当然监控传统应用也不是吃干饭的,所以就是容器和非容器他都支持,所有的监控系统都具备这个流程,_-自动化监控系统prometheus&grafana实战

React 组件封装之 Search 搜索_react search-程序员宅基地

文章浏览阅读4.7k次。输入关键字,可以通过键盘的搜索按钮完成搜索功能。_react search