python爬虫入门教程(非常详细)-程序员宅基地

一、基础入门

1.1 什么是爬虫

爬虫(spider,又网络爬虫),是指向网站/网络发起请求,获取资源后分析并提取有用数据的程序。

从技术层面来说就是 通过程序模拟浏览器请求站点的行为,把站点返回的HTML代码/JSON数据/二进制数据(图片、视频) 爬到本地,进而提取自己需要的数据,存放起来使用。

1.2 爬虫基本流程

用户获取网络数据的方式:

方式1:浏览器提交请求—>下载网页代码—>解析成页面

方式2:模拟浏览器发送请求(获取网页代码)->提取有用的数据->存放于数据库或文件中

爬虫要做的就是方式2。

1.2.1 发起请求

使用http库向目标站点发起请求,即发送一个Request

Request包含:请求头、请求体等

Request模块缺陷:不能执行JS 和CSS 代码

1.2.2 获取响应内容

如果服务器能正常响应,则会得到一个Response

Response包含:html,json,图片,视频等

1.2.3 解析内容

解析html数据:正则表达式(RE模块)、xpath(主要使用)、beautiful soup、css

解析json数据:json模块

解析二进制数据:以wb的方式写入文件

1.2.4 保存数据

数据库(MySQL,Mongdb、Redis)或 文件的形式。

1.3 http协议 请求与响应

http协议

Request:用户将自己的信息通过浏览器(socket client)发送给服务器(socket server)

Response:服务器接收请求,分析用户发来的请求信息,然后返回数据(返回的数据中可能包含其他链接,如:图片,js,css等)

ps:浏览器在接收Response后,会解析其内容来显示给用户,而爬虫程序在模拟浏览器发送请求然后接收Response后,是要提取其中的有用数据。

对Python感兴趣或者是正在学习的小伙伴,可以加入我们的Python学习扣qun:784758214,从0基础的python脚本到web开发、爬虫、django、数据挖掘数据分析等,0基础到项目实战的资料都有整理。送给每一位python的小伙伴!每晚分享一些学习的方法和需要注意的小细节,学习路线规划,利用编程赚外快。快点击加入我们的 python学习圈

1.3.1 request

请求方式

常见的请求方式:GET / POST

请求的URL

url全球统一资源定位符,用来定义互联网上一个唯一的资源 例如:一张图片、一个文件、一段视频都可以用url唯一确定

请求头

User-agent:请求头中如果没有user-agent客户端配置,服务端可能将你当做一个非法用户host;

cookies:cookie用来保存登录信息

注意:一般做爬虫都会加上请求头。

请求头需要注意的参数:

- Referrer:访问源至哪里来(一些大型网站,会通过Referrer 做防盗链策略;所有爬虫也要注意模拟)

- User-Agent:访问的浏览器(要加上否则会被当成爬虫程序)

- cookie:请求头注意携带

请求体

请求体 如果是get方式,请求体没有内容 (get请求的请求体放在 url后面参数中,直接能看到) 如果是post方式,请求体是format data

ps:

1、登录窗口,文件上传等,信息都会被附加到请求体内

2、登录,输入错误的用户名密码,然后提交,就可以看到post,正确登录后页面通常会跳转,无法捕捉到post

1.3.2 response

(1)响应状态码

200:代表成功

301:代表跳转

404:文件不存在

403:无权限访问

502:服务器错误

(2)response header

响应头需要注意的参数:Set-Cookie:BDSVRTM=0; path=/:可能有多个,是来告诉浏览器,把cookie保存下来

(3)preview就是网页源代码

json数据

如网页html,图片

二进制数据等

二、基础模块

2.1 requests

requests是python实现的简单易用的HTTP库,是由urllib的升级而来。

开源地址:https://github.com/pydmy…

中文API:http://docs.python-requests.o…

2.2 re 正则表达式

在 Python 中使用内置的 re 模块来使用正则表达式。

缺点:处理数据不稳定、工作量大

2.3 XPath

Xpath(XML Path Language) 是一门在 XML 文档中查找信息的语言,可用来在 XML 文档中对元素和属性进行遍历。

在python中主要使用 lxml 库来进行xpath获取(在框架中不使用lxml,框架内直接使用xpath即可)

lxml 是 一个HTML/XML的解析器,主要的功能是如何解析和提取 HTML/XML 数据。

lxml和正则一样,也是用 C 实现的,是一款高性能的 Python HTML/XML 解析器,我们可以利用之前学习的XPath语法,来快速的定位特定元素以及节点信息。

2.4 BeautifulSoup

和 lxml 一样,Beautiful Soup 也是一个HTML/XML的解析器,主要的功能也是如何解析和提取 HTML/XML 数据。

使用BeautifulSoup需要导入bs4库

缺点:相对正则和xpath处理速度慢

优点:使用简单

2.5 Json

JSON(JavaScript Object Notation) 是一种轻量级的数据交换格式,它使得人们很容易的进行阅读和编写。同时也方便了机器进行解析和生成。适用于进行数据交互的场景,比如网站前台与后台之间的数据交互。

在python中主要使用 json 模块来处理 json数据。Json解析网站:

https://www.sojson.com/simple…

2.6 threading

使用threading模块创建线程,直接从threading.Thread继承,然后重写__init__方法和run方法

三、方法实例

3.1 get方法实例

demo_get.py

3.2 post方法实例

demo_post.py

3.3 添加代理

demo_proxies.py

3.4 获取ajax类数据实例

demo_ajax.py

3.5 使用多线程实例

demo_thread.py

四、爬虫框架

4.1 Srcapy框架

Scrapy是用纯Python实现一个为了爬取网站数据、提取结构性数据而编写的应用框架,用途非常广泛。

Scrapy 使用了 Twisted’twɪstɪd异步网络框架来处理网络通讯,可以加快我们的下载速度,不用自己去实现异步框架,并且包含了各种中间件接口,可以灵活的完成各种需求。

4.2 Scrapy架构图

4.3 Scrapy主要组件

Scrapy Engine(引擎): 负责Spider、ItemPipeline、Downloader、Scheduler中间的通讯,信号、数据传递等。

Scheduler(调度器): 它负责接受引擎发送过来的Request请求,并按照一定的方式进行整理排列,入队,当引擎需要时,交还给引擎。

Downloader(下载器):负责下载Scrapy Engine(引擎)发送的所有Requests请求,并将其获取到的Responses交还给Scrapy Engine(引擎),由引擎交给Spider来处理,

Spider(爬虫):它负责处理所有Responses,从中分析提取数据,获取Item字段需要的数据,并将需要跟进的URL提交给引擎,再次进入Scheduler(调度器),

Item Pipeline(管道):它负责处理Spider中获取到的Item,并进行进行后期处理(详细分析、过滤、存储等)的地方.

Downloader Middlewares(下载中间件):你可以当作是一个可以自定义扩展下载功能的组件。

Spider Middlewares(Spider中间件):你可以理解为是一个可以自定扩展和操作引擎和Spider中间通信的功能组件(比如进入Spider的Responses;和从Spider出去的Requests)

4.4 Scrapy的运作流程

引擎:Hi!Spider, 你要处理哪一个网站?

Spider:老大要我处理xxxx.com。

引擎:你把第一个需要处理的URL给我吧。

Spider:给你,第一个URL是xxxxxxx.com。

引擎:Hi!调度器,我这有request请求你帮我排序入队一下。

调度器:好的,正在处理你等一下。

引擎:Hi!调度器,把你处理好的request请求给我。

调度器:给你,这是我处理好的request

引擎:Hi!下载器,你按照老大的下载中间件的设置帮我下载一下这个request请求

下载器:好的!给你,这是下载好的东西。(如果失败:sorry,这个request下载失败了。然后引擎告诉调度器,这个request下载失败了,你记录一下,我们待会儿再下载)

引擎:Hi!Spider,这是下载好的东西,并且已经按照老大的下载中间件处理过了,你自己处理一下(注意!这儿responses默认是交给def parse()这个函数处理的)

Spider:(处理完毕数据之后对于需要跟进的URL),Hi!引擎,我这里有两个结果,这个是我需要跟进的URL,还有这个是我获取到的Item数据。

引擎:Hi !管道 我这儿有个item你帮我处理一下!调度器!这是需要跟进URL你帮我处理下。然后从第四步开始循环,直到获取完老大需要全部信息。

管道``调度器:好的,现在就做!

4.5 制作Scrapy爬虫4步曲

- 新建爬虫项目

scrapy startproject mySpider - 明确目标 (编写items.py)

打开mySpider目录下的items.py - 制作爬虫 (spiders/xxspider.py)

scrapy genspider gushi365 “gushi365.com” - 存储内容 (pipelines.py)

设计管道存储爬取内容

五、常用工具

5.1 fidder

fidder是一款抓包工具,主要用于手机抓包。

5.2 XPath Helper

xpath helper插件是一款免费的chrome爬虫网页解析工具。可以帮助用户解决在获取xpath路径时无法正常定位等问题。

谷歌浏览器插件xpath helper 的安装和使用:

https://jingyan.baidu.com/art…

六、分布式爬虫

6.1 scrapy-redis

Scrapy-redis是为了更方便地实现Scrapy分布式爬取,而提供了一些以redis为基础的组件(pip install scrapy-redis)

6.2 分布式策略

Master端(核心服务器) :搭建一个Redis数据库,不负责爬取,只负责url指纹判重、Request的分配,以及数据的存储。

这里给大家分享一份Python全套学习资料,包括学习路线、软件、源码、视频、面试题等等,都是我自己学习时整理的,希望可以对正在学习或者想要学习Python的朋友有帮助!

CSDN大礼包:全网最全《全套Python学习资料》免费分享

学习资源推荐

除了上述分享,如果你也喜欢编程,想通过学习Python获取更高薪资,这里给大家分享一份Python学习资料。

这里给大家展示一下我进的兼职群和最近接单的截图

朋友们如果有需要的话,可以V扫描下方二维码联系领取,也可以内推兼职群哦~

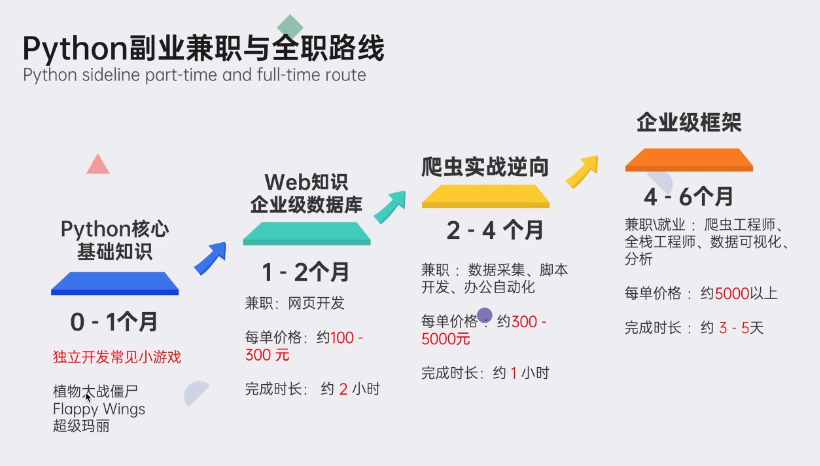

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

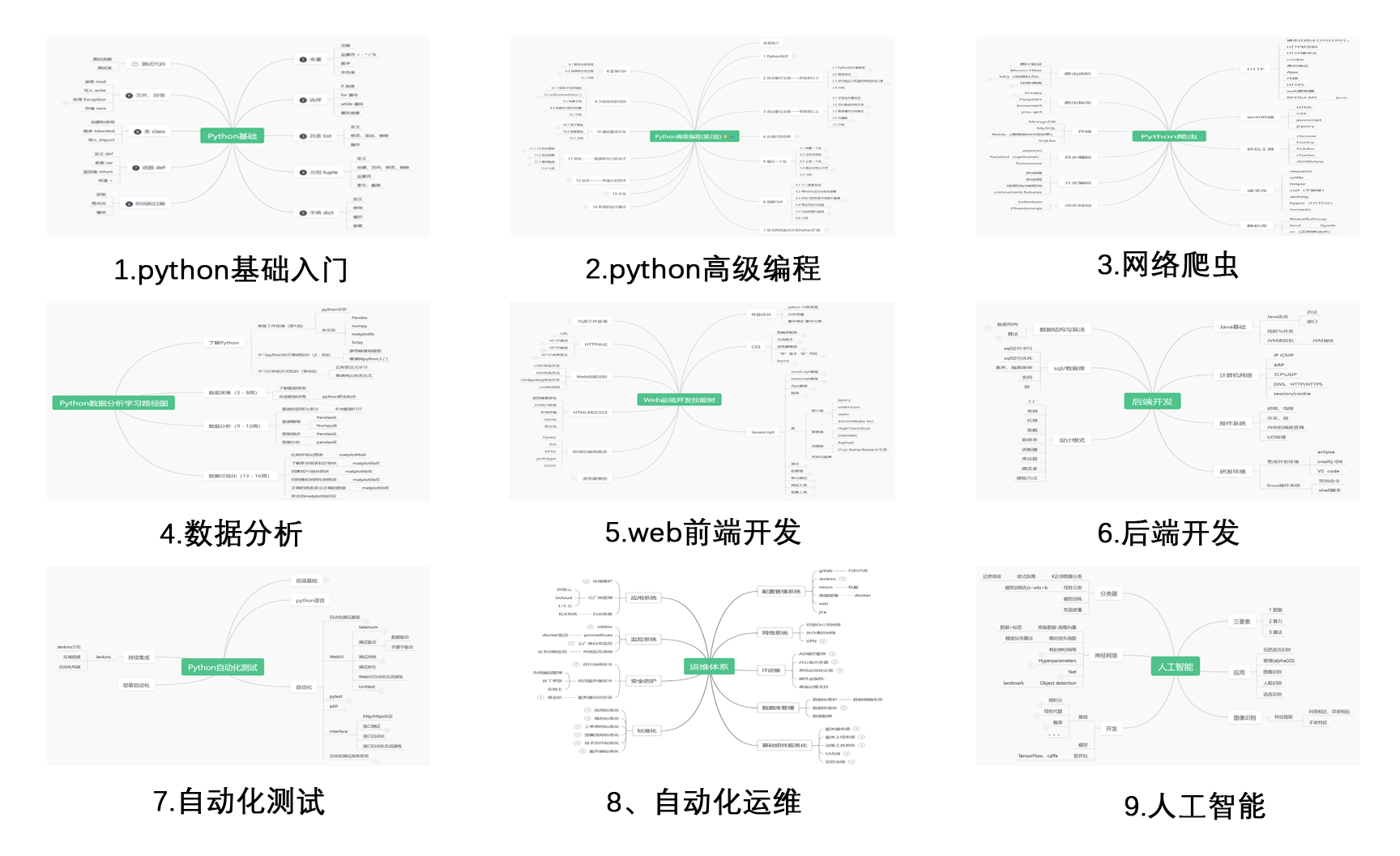

### 1.Python学习路线

### 1.Python学习路线

2.Python基础学习

01.开发工具

02.学习笔记

03.学习视频

3.Python小白必备手册

4.数据分析全套资源

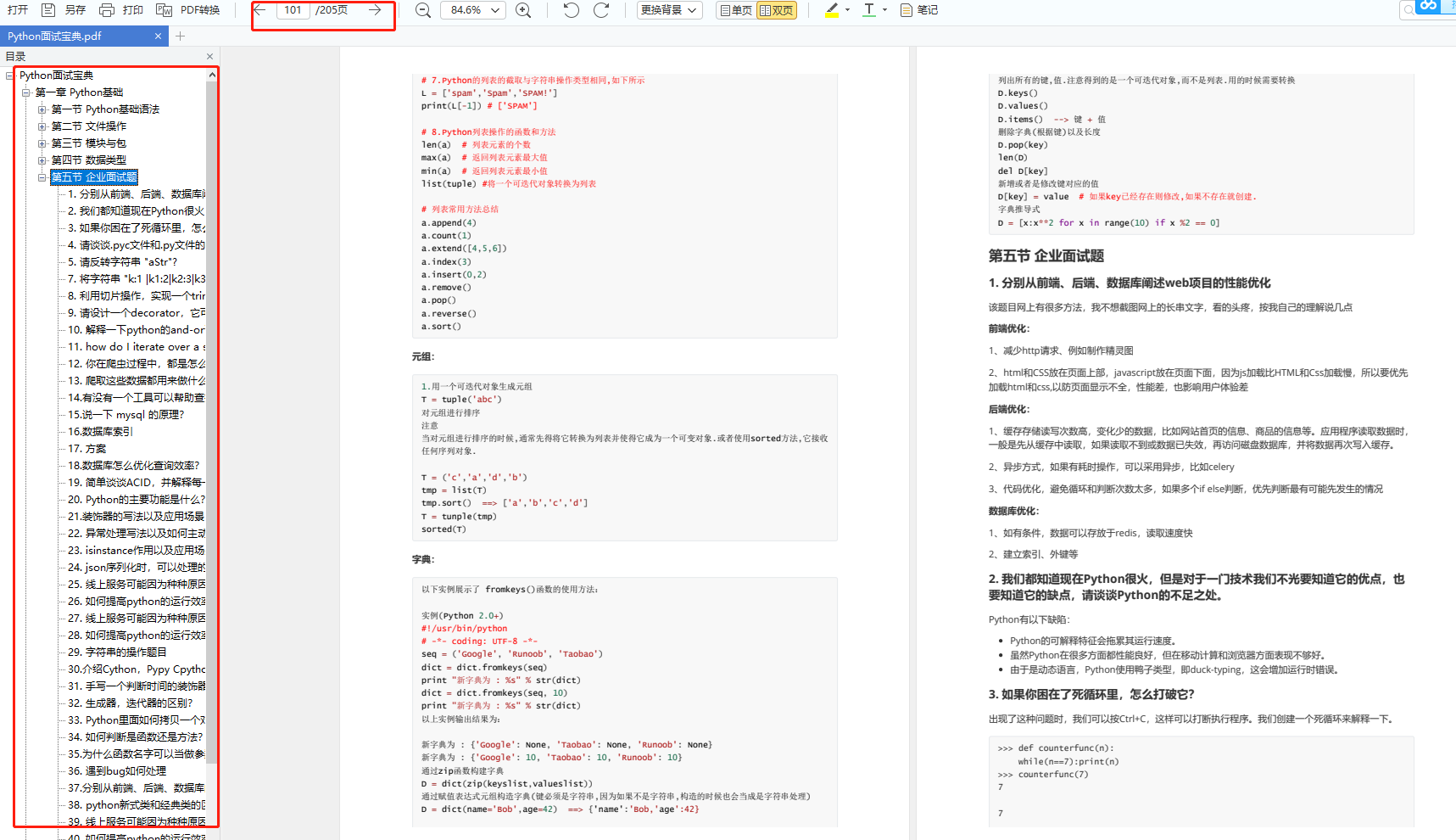

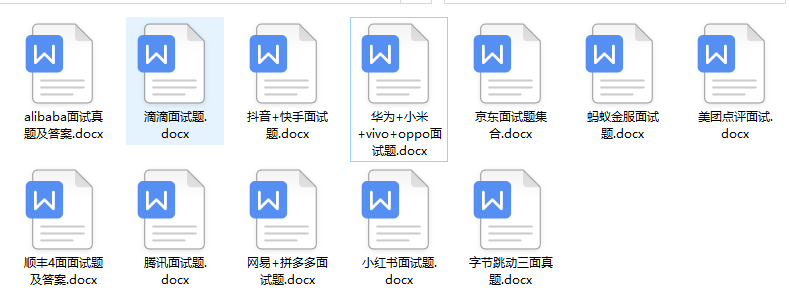

5.Python面试集锦

01.面试资料

02.简历模板

因篇幅有限,仅展示部分资料,添加上方即可获取

------ 本文转自网络,如有侵权,请联系删除 ------

智能推荐

内省(Inspector)与注解(Annotation)_内省机制-程序员宅基地

文章浏览阅读427次。目录1.内省机制2.内省机制对于属性的操作3.内省属性的注意事项4.注解的功能5.注解声明6.注解修饰目标7.注解生命周期8.注解属性9.注解的使用10.反射对注解的操作1.内省机制 在实际编程中,我们常常需要一些用来包装值对象的类,例如Student、Employee、Order,这些类中往往没有业务方法,只是为了把需要处理的实体对象进行封装,有这样的特征: 属性都是私有的; 有无参的public构造方法; 对_内省机制

Windows 10_x64 PL/SQL 链接64位 Oracle_oraclexe112_win64.zip 云盘-程序员宅基地

文章浏览阅读1.3k次。环境:Windows 10_x64 Oracle11.2XE win_x64PL/SQL Developer 32位过程:1. 首先是Oracle 数据库下载、安装(对于简易版安装,注意记住起始安装的密码,其他的东西基本上下一步下一步就行了)。安装完成后可以在菜单中查找到(运行SQL命令)启动该程序后。登陆前记得使用conn命令。链接数据库。如果需要_oraclexe112_win64.zip 云盘

nokia c503_nokiac503密码可以设置几位-程序员宅基地

文章浏览阅读949次。ovi定位问题:设置--->手机---> 应用程序设置 ---> 定位 定位方法(勾选辅助GPS,集成GPS)定位服务器(自动,接入点CMNET,地址:supl.nokia.com)_nokiac503密码可以设置几位

怎样才能写好项目文档_项目文档怎么写-程序员宅基地

文章浏览阅读1.6k次。怎样才能写好项目文档_项目文档怎么写

电脑计算机简单密码设置方法,电脑开机密码怎么设置,开机密码设置很简单!-程序员宅基地

文章浏览阅读6.4k次。电脑开机密码就像我们手机锁屏密码一样,都是想要自己私密的空间不被侵犯。很多小伙伴的手机都有这是锁屏密码,那么电脑开机密码又是如何设置的呢?如果你不知道如何设置,下面一起看下小编设置电脑开机密码的步骤吧。随着科技的高速发展,电脑隐私成为了我们一个重要的话题点,对于个人隐私内容都不想让同事还是朋友知道,所以往往我们喜欢给电脑设置开机密码。下面小编教你如何设置电脑开机密码,希望能帮助您保护到个人电脑的隐..._开机密码怎么设置电脑开机密码

固态硬盘简介-程序员宅基地

文章浏览阅读228次。固态硬盘的存储介质分为两种,一种是采用闪存也就是FLASH芯片作为存储介质,另外一种是采用DRAM作为存储介质。小康先说说使用DRAM的固态硬盘:采用DRAM作为存储介质,目前应用范围较窄。它仿效传统硬盘的设计、可被绝大部分操作系统的文件系统工具进行卷设置和管理,并提供工业标准的PCI和FC接口用于连接主机或者服务器。应用方式可分为SSD硬盘和SSD硬盘阵列两种。它是一种高性能的存储器,而且使..._hfs的固态硬盘如何使用

随便推点

Java maxchars方法_LearningJDK/CharsetEncoder.java at master · sx2714732/LearningJDK · GitHub-程序员宅基地

文章浏览阅读225次。/** Copyright (c) 2000, 2017, Oracle and/or its affiliates. All rights reserved.* DO NOT ALTER OR REMOVE COPYRIGHT NOTICES OR THIS FILE HEADER.** This code is free software; you can redistribute it an..._learningjdk如何使用

mfc42.dll文件丢失导致程序无法运行问题-程序员宅基地

文章浏览阅读904次,点赞16次,收藏13次。其实很多用户玩单机游戏或者安装软件的时候就出现过这种问题,如果是新手第一时间会认为是软件或游戏出错了,其实并不是这样,其主要原因就是你电脑系统的该dll文件丢失了或没有安装一些系统软件平台所需要的动态链接库,这时你可以下载这个mfc42.dll文件(挑选合适的版本文件)把它放入到程序或系统目录中,当我们执行某一个.exe程序时,相应的DLL文件就会被调用,因此将缺失的文件放回到原目录之后就能打开你的软件或游戏了.那么出现mfc42.dll丢失要怎么解决?

react中使用svg作为字体图标,使用react-svg组件-程序员宅基地

文章浏览阅读5.8k次,点赞6次,收藏11次。公司一直使用svg作为字体图标,从一开始我使用svg字体图标的方式也是通过img标签引入的,直到最近公司做的业务有个附件预览需求是这样的:展示几种不同的样式,当预览的附件里面没有数据和有数据的时候svg图标展示的样式不一样,鼠标移入的时候,又展示不同的样式图标,一开始感觉就是把所有要展示的svg图标切出来就行了,但是后来发现有几种图标没有,如图,其中的模板有数据时,和鼠标经过-无数据悬停态的时候的svg图标没有,于是我和ui就去要了一下图标,但是ui说svg可以改颜色,并让我按照这个改下就行,不必要_react-svg

图像 分割 - Fast-SCNN: Fast Semantic Segmentation Network (arXiv 2019)-程序员宅基地

文章浏览阅读582次,点赞2次,收藏3次。编码器-解码器框架是用于离线语义图像分割的最先进的框架。随着自主系统的兴起,实时计算越来越受欢迎。在本文中,我们介绍了快速分割卷积神经网络(Fast-SCNN),这是一种针对高分辨率图像数据(1024×2048px)的实时语义分割模型,适用于低内存嵌入式设备上的高效计算。在现有的两种快速分割分支方法的基础上,我们引入了我们的“学习下采样”模块,该模块同时计算多个分辨率分支的低级特征。_fast-scnn

python read_csv dtype_Pandas read_csv low_memory和dtype选项-程序员宅基地

文章浏览阅读1.8k次。已弃用的低内存选项low_memory选项没有被正确地弃用,但它应该被弃用,因为它实际上没有做任何不同的事情[source]出现此low_memory警告的原因是,猜测每个列的数据类型需要大量内存。Pandas试图通过分析每列中的数据来确定要设置的数据类型。数据类型猜测(非常糟糕)Pandas只能在读取整个文件后确定列的数据类型。这意味着在读取整个文件之前无法真正解析任何内容,除非您在读取最后一个..._pandas low_memory

【C语言入门】将任意10个数输入一维数组,找出最大数放到最前面,最小数放到最后面。_编写程序,从键盘录入n个数放入一维数组中,找出最大数放到最前面,最小数放到最后面-程序员宅基地

文章浏览阅读1.3k次,点赞3次,收藏6次。题目:将任意10个数输入一维数组,找出最大数放到最前面,最小数放到最后面。_编写程序,从键盘录入n个数放入一维数组中,找出最大数放到最前面,最小数放到最后面