”灾难性遗忘“ 的搜索结果

深度学习笔记:灾难性遗忘

标签: 笔记

【ICML2018】中提到,神经网络的所有的极小值都是连通在一起的;同时给出了如何从一个极小值找到一条通路连到另一个极小值的算法。——>从原始任务的某个极小值出发,在优化新任务的时候。,就可以保证原始任务不受...

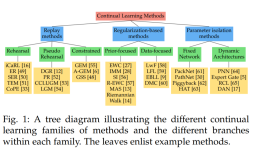

造成灾难性遗忘的一个主要原因是, 传统模型假设数据分布是固定或平稳的, 训练样本是独立同分布的, 所 以模型可以一遍又一遍地看到所有任务相同的数据, 但当数据变为连续的数据流时, 训练数据的分布就是非平稳的...

这可能会出现“灾难性遗忘”的问题。而伪排练是一个很好的解决方案:使用原始模型标签实例,并通过微调更新进行混合。当你优化连续两次的学习问题可能会出现灾难性遗忘问题,第一个问题的权重被用来作为第二个问题...

神经网络模型中灾难性遗忘研究的综述.pdf

在碎片化阅读充斥眼球的时代,越来越少的人会去关注每篇论文背后的探索和思考。...深度学习领域一直存在一个比较严重的问题——“灾难性遗忘”,即一旦使用新的数据集去训练已有的模型,该模型将会失去对原数据集识...

在神经网络中测量灾难性遗忘

标签: 灾难性遗忘

探讨了灾难性遗忘,以及测量,是这方面的首选之作,很有必要看一下

灾难性遗忘(catastrophic forgetting)学习笔记

目前多任务通用模型的背景下,灾难性遗忘(catastrophic forgetting)是一个绕不开的话题,而我们计划的风格迁移也涉及到此类问题,特记录下来备忘。

在自然认知的系统中,遗忘是一个逐步的过程,除极少数情况,人不会突然失忆。但是在对应的计算模型,尤其是Gradient Based Connectionism(联结主义)模型中,模型往往表现的是Catastrophic Forgetting(...

增量学习通过逐步更新模型来学习新数据,以保留已有知识并减轻灾难性遗忘问题。策略包括:记忆回放,通过混合先前样本与新数据进行训练;增量训练,将新数据逐渐融入模型中;调整学习率以稳定旧知识保留;使用权重...

人类特别擅长把旧技能转移到新问题上。...这种现象被相当贴切地称为“灾难性遗忘”,谴责现在的人工智能只是“一招鲜”。如今,从海马体和我们大脑的记忆存储系统中得到灵感,DeepMind和敦帝国学院(Impe...

由于智能的标志之一是学习和存储多项任务,因此如何在多项任务上训练神经网络(并解决灾难性遗忘)的问题极为重要。 有一种想法是改变训练数据,使每项任务的训练样本相互交错。例如,假设我们有 3 个任务

该存储库包含一个项目的代码,该项目使用学生-教师框架调查灾难性遗忘。 该项目是我在牛津大学获得计算机科学硕士学位的论文的一部分,并由Andrew Saxe和Sebastian Goldt指导。 此代码允许为学生指定一个持续的学习...

克服神经网络中的灾难性遗忘IntroductionResultsEWC Extends Memory Lifetime for Random PatternsEWC Allows Continual Learning in a Supervised Learning ContextEWC Allows Continual Learning in a ...

读取图像实验代码无灾难性遗忘的目标检测器增量学习 这是我们在 ICCV 2017 上发表的论文的代码发布。 要求 代码是为 Python 3.5 和 TensorFlow 1.5 编写的(对于较新的版本,可能需要稍作修改)。 您还需要安装正常...

作者的实验结果显示,相比于纯粹精调,这些方法可以明显改善模型在非精调数据集上的泛化性能,证明它们确实能够有效缓解泛化能力的遗忘。作者比较了不同的方法来缓解这种遗忘,包括持续学习方法(L1、L2正则化、知识蒸馏)...

该方法主要通过增加恒定块扩展模型层数,使模型在增量训练过程中仅训练新增层、冻结原始层,保持模型原有能力,防止模型出现灾难性遗忘现象。但有两点存疑:目前来说mistral要好于llama,为啥不用mistral进行实验...

来源:混沌巡洋舰灾难性遗忘指的是:不像人类,当深度学习模型被训练完成新的任务时,他们很快就会忘记以前学过的东西。8月13号的自然通讯论文Brain-inspired replay for...

——因为AI遭遇了「灾难性遗忘」!所谓灾难性遗忘,是机器学习中一种常见的现象。在深度神经网络学习不同任务的时候,相关权重的快速变化会损害先前任务的表现。而现在,这项图灵奖得主Bengio参与的研究证明,在街机...

文中提出一种层次架构,包括提取不同任务基本表征的原语学习模块和特定于任务的策略学习模块,其中原语学习利用N(0,1)分布假设来寻找不同任务间的联系,并通过重建损失来标识不同任务。在模拟环境中进行插销和开门...

解决灾难性遗忘问题的方法有很多,但目前还没有一种方法能完全解决这个问题。总之,尽管目前已有许多方法在一定程度上缓解灾难性遗忘问题,但仍需不断探索和发展新方法以更好地解决这一问题。问题复杂性:不同的问题...

对于灾难性遗忘,解决方案通常包括增量学习、迁移学习、经验回放等。这些方法在许多场景下都能有效地缓解灾难性遗忘,从而使模型能够在学习新任务或新数据时保留先前学到的知识。然而,在某些复杂的场景中,如神经...

推荐文章

- C++零碎知识点(一)-程序员宅基地

- 【Python学习笔记】Coursera课程《Python Data Structures》 密歇根大学 Charles Severance——Week5 Dictionary课堂笔记...-程序员宅基地

- v-html 解析字符串到 html 换行显示_html字符串 v-html-程序员宅基地

- 招收跨专业考计算机的学校,跨专业考研,接受跨专业考研的学校。-程序员宅基地

- 数学模型预测模型_改进著名的nfl预测模型-程序员宅基地

- ELK-FileBeat入门_filebeat 6.5.4 - windows-程序员宅基地

- 微信小程序架构图与开发_微信小程序框架图-程序员宅基地

- Node.js 下载与安装教程_node下载-程序员宅基地

- MySQL报错:The server time zone value '�й���ʱ��' is unrecognized or represents more than one time zone_连接失败! the server time zone value ' й ' is-程序员宅基地

- 数学与生活——读书笔记-程序员宅基地